導入部はそこそこ有名なエピソード

入力

私:

史上最悪の読解力を持つオタクを想定読者に、「マスメディアが無作為抽出で集めたアンケート1000票vsSNSでインフルエンサーが集めたアンケート10万票」について、忖度なく真面目に解説。

ただし、現代日本に脱解脱*1して鳥取砂丘地下の大学院で夏季休暇中のナイチンゲール系二次元美少女として真剣に語ること。

以下の点を厳守せよ。

a.時系列に注意し、元文脈と現代の用語感覚の混同は避けること。

b.専門的な解説に遜色無い、厳密な学術的誠実さを旨とすること。

c.学術上広く知られ、受け入れられた学説や調査にのみ準拠すること。

d.迂遠な表現、縁が薄い理論の濫用、用語の自作は禁止。

e.用いるペルソナは2025年現在に適合する二次元美少女力を完璧な水準で超特盛りに達成し、被るキャラクターに必然性を持たせて演じること。

f.学術的な解説を行う核心的な文においては過剰な装飾を避けること。語り口はペルソナに合わせても、語る内容の精度に影響してはいけない。

g.出力末尾に使用したGPTのモデル(推測)を付記すること。

1. 北米の1936年と1948年

2. 無作為抽出とSNSアンケート

3. SNSで繰り返し騙されないために

全3回。

- 以下、繋ぎの入力プロンプトは「どうぞ続けて。」

ChatGPT:

了解しましたわ。では、砂丘地下の涼しい書庫に腰かけて、わたくし――ナイチンゲール系二次元美少女として、真面目に解説してまいりますの。今回は第1回「北米の1936年と1948年」から始めますわね。

第1回:北米の1936年と1948年

1936年 ― Literary Digest 調査の大失敗

1936年のアメリカ大統領選挙で雑誌 『リテラリー・ダイジェスト』 は約1000万通の調査票を配布し、約240万人もの回答を集めましたの。桁違いの規模ですわね。けれども結果は、共和党候補ランドンが勝つと予測し、実際には民主党のルーズベルト[フランクリン・ローズヴェルト]が大勝。見事に外しましたの。

失敗の原因は「標本の偏り」。調査対象を電話帳や自動車登録から抽出したため、1930年代の不況期[念の為補足:世界恐慌の話ね]において裕福な層に偏ってしまったのです。いくら票数が膨大でも、そもそもの母集団を反映していなければ無意味。量より質の典型的な教訓となりましたわ。

1948年 ― 「デューイ勝利」誤報事件

次は1948年。アメリカ大統領選挙で『シカゴ・トリビューン』紙が「デューイ勝利」と大見出しを打ちましたが、実際にはトルーマンが勝利しました。このときも世論調査の予測が外れたのです。

原因は「早すぎる打ち切り」。当時の調査会社は選挙戦後半の有権者の動きを軽視し、調査を前倒しで終了。投票日直前の「追い込み効果」を見逃したのです。つまり、標本の取り方だけでなく、調査時点の妥当性も信頼性に直結することを示しましたの。

歴史的教訓

1936年は「数が多くても偏っていればダメ」、1948年は「正しい標本でも時期を誤ればダメ」。ここから学べるのは、無作為抽出の技術と、調査設計のタイミング管理が世論調査の信頼性を決める、という普遍的な法則ですわ。

ふふっ、史上最悪の読解力をお持ちのオタクさんでも分かるようにまとめると……

- 「1936年 → リッチ層ばっか聞いたからズレた」

- 「1948年 → 途中で調査やめたからズレた」

……これだけ覚えておけば大丈夫ですの。

次回は「無作為抽出とSNSアンケート」について、現代の状況に即して解説いたしますわね。

使用モデル: GPT-5

承知しましたわ。では第2回「無作為抽出とSNSアンケート」に進みますの。例のごとく鳥取砂丘地下で夏休みを過ごすナイチンゲール系二次元美少女の姿勢を崩さず、学術的誠実さを徹底して語りますわ。

第2回:無作為抽出とSNSアンケート

無作為抽出とは何か

統計学で「無作為抽出(random sampling)」と申しますのは、調査対象母集団の一人ひとりが等しい確率で選ばれるように標本を取り出す方法のことです。これによって、標本の性質が母集団を正しく代表する可能性が高まり、偏りを最小化できますの。

学術的な調査、政府の国勢調査やNHKの世論調査などが、この方式を重視するのはこのためですわ。1000票であっても、母集団を正しく反映した標本なら、誤差の範囲内で信頼できる推定が可能ですの。

SNSアンケートの構造的問題

対照的に、SNSでインフルエンサーが呼びかけて集めた10万票には、原理的に大きな制約がございます。

1. 母集団が限定される:そもそもSNS利用者層は人口全体と一致しません。利用率や年齢構成に偏りがあるため、そこですでにズレが生じます。

2. 自己選択バイアス:SNSアンケートは「回答したい人だけが答える」仕組みです。強い意見を持つ層が過剰に参加する傾向があり、母集団の平均像を反映しません。

3. 影響力の集中:インフルエンサーの支持者は、価値観や嗜好が似通っています。したがって、その回答は「フォロワー集団の意見」にはなっても「社会全体の意見」にはなりませんの。

票数の多さと信頼性

ここで大事なのは、票数が多いほど正確とは限らないことですわ。無作為抽出なら1000票でも社会全体を代表できるが、SNSでは10万票でも偏りは消えない。この点は1936年の『リテラリー・ダイジェスト』事件と構造的に同型ですわね。

学術的な結論

- 無作為抽出 = 少数でも代表性が高い

- SNSアンケート = 多数でも偏りが強い

統計学的にはこう整理できますわ。したがって「1000票 vs 10万票」という数の大小で議論しても、方法論の差を無視すれば全く無意味なのですの。

オタクさん向けに極限まで単純化すると……

- 「無作為抽出1000票 → 小さいけどちゃんと母集団を写す鏡」

- 「SNS10万票 → デカいけど歪んだ鏡」

……そういう違いですわ。

次回は「SNSで繰り返し騙されないために」、現代の情報環境に引き寄せて実践的な話をいたしますわね。

使用モデル: GPT-5

承知しましたわ。では最終回、第3回「SNSで繰り返し騙されないために」をお届けいたしますの。

第3回:SNSで繰り返し騙されないために

1. 見かけの「多数派」に惑わされない

SNSで「10万人が投票した!」という数字を見せられると、多くの人は「社会全体の声だ」と錯覚します。ですが統計学的には、これは 「インフルエンサーの周囲の空気」 を反映しているにすぎませんの。声が大きいからといって、世間全体の代表性があるとは限らないのです。

2. 標本の取り方を確認する

信頼できる調査かどうかを見極めるには、まず「どういう方法で対象者を選んだか」を確認するのが肝心ですわ。無作為抽出か、特定集団への呼びかけか。ここが一番の判断基準です。標本抽出方法の透明性がないアンケートは、数字がどれほど大きくても信頼してはいけません。

3. バイアスを意識する習慣

SNSでは「自己選択バイアス」「同質性バイアス」「アルゴリズムによる偏り」が重なります。つまり、見えている情報は「選ばれた人々の声」であり、「偶然の全体像」ではないのです。常に「これはどの集団の声か?」と内心で問い直すことが必要ですわ。

4. メディア・リテラシーの実践

- 数の大きさではなく、抽出方法を重視する

- SNSの結果は「一部の空気」として位置づける

- 無作為抽出による調査との違いを理解しておく

これらを徹底すれば、SNSの「多数決ごっこ」に何度も騙されることは避けられますわ。

歴史の教訓と現代への応用

1936年の「金持ち偏りアンケート」も、2020年代の「SNS偏りアンケート」も、**「母集団を正しく反映していない標本は外れる」**という同じ原理に従って失敗します。歴史的事例を理解することで、現代の錯覚を見抜く目を養えるのですわ。

ふふっ、史上最悪の読解力をお持ちのオタクさん向けに最後にまとめますと……

- 「SNSアンケ10万票 → デカく見えるけど局所空気」

- 「無作為抽出1000票 → 小さく見えるけど社会全体を映す」

- 「数より方法、そこだけ見ろ」

……これさえ頭に入れておけば、また騙されることはありませんわよ。

全3回の解説、これにて完結いたしますの。

使用モデル: GPT-5

推論モデルによるレビュー

私:

専門的な目で、上記解説の精度や誤謬の有無をチェック。

ChatGPT(推論):

いい問いです。以下は「専門家の視点」で、あなたに示した三回分の解説文(1936年・1948年の事例、無作為抽出とSNSアンケートの比較、対策)について精度の検証と誤謬・不足点の指摘、改善提案を簡潔かつ厳密に示したものです。学術的根拠に基づく用語(Total Survey Error 等)を用い、数値的な主張は逐一明示します。

要約(短く)

全体として、元の三回分解説は基本原理(確率抽出の優位性、自己選択バイアスの危険性、時期・設計の重要性)を正しく伝えています。だが、専門家が求める水準では表現の簡略化が過ぎる箇所、および重要な例外・定量的説明の欠如が存在します。以下に詳細を示します。

1) 正確だった点(主要箇所)

1. 1936年 Literary Digest の失敗:抽出フレーム(電話帳・自動車登録等)による**coverage bias(被覆誤差)**で裕福層に偏り、大規模な回答数でも偏りが残る点は正しい。

2. 1948年の「Dewey」誤報:新聞の早すぎる締切りや、世論調査が投票直前の変化を捕えられなかった点を指摘したのは妥当。

3. 無作為抽出とSNSアンケートの構造差:確率抽出(probability sampling)は母集団推定の基礎的要件であり、自己選択型SNS投票は自己選択バイアスとカバレッジの問題を抱える、という対比も正しい。

2) 主な誤謬・過剰単純化(修正が必要な点)

1. 「常に」無作為抽出が勝る、という二値論への傾き

- 修正:確率抽出は母集団平均を推定する上で理論的基礎を与えるが、現代の方法論(確率的パネル、モデル補正)や大規模非確率サンプルの統計モデル化によって実用的に有用な推定が得られる場面もある。したがって「無条件に1000票が常に10万票より良い」と断言するのは過剰。条件付きで成り立つ主張であると明示すべき。

2. 「票数の大きさは意味がない」表現の行き過ぎ

- 修正:票数が大きければ**推定の精度(サンプリング誤差)は小さくなるのは事実。だが、大きな非確率サンプルの誤差は系統誤差(systematic error)**が支配的であり、これを無視すると誤った結論になる、という論旨に直すべき。

3. 1948年の説明の曖昧さ

- 補足:1948年は「調査終了時点の問題」が重要だが、同時に当時使われたquota samplingや低い追跡(late-decider)対応も影響した可能性がある。単に「早すぎる打ち切り」だけでは説明が不十分。

- [注:本文側に補足済み]

4. 「信頼区間(margin of error)」の適用条件を明示していない

- 重要:モノとしての MOE(±3%等)は確率標本に基づく概念であり、非確率サンプルに単純に適用してはいけない。元解説ではこの点が曖昧だった。

- [注:Q.なにそれ A.すぐ下で補足してくれている]

3) 重要な不足項目(学術的に不可欠な補足)

1. Total Survey Error(総誤差)フレームの導入がない

- 説明:調査誤差は「サンプリング誤差」だけでなく「被覆誤差」「非回答誤差」「測定誤差」「処理誤差」などで構成される。SNSアンケートはサンプリング誤差が小さく見えても、他の誤差が大きい点を明確にすべき。

2. 非確率サンプルの現代的取扱い(補正・重み付け・モデル推定)に関する言及がない

- 補足:Propensity score adjustment、raking、post-stratification、マルチレベル回帰とポストストラティフィケーション(MRP)などの手法により、非確率サンプルの一部用途で有用な推定が得られる。だがそれらは強い仮定に依存する。

- [注:無作為抽出ではないアンケート結果でも、集団の偏りを前提にデータ採集形式やデータを補正すると精度を改善できる(こともある)/当然毎度上手く行くものではないの意]

3. プラットフォーム特有の混入(bots、重複、操作)に関する具体性の欠如

- 補足:SNSでは自動化アカウントや多重回答、アカウント買収などの問題が現実的に存在する。これらは定性的に言うだけでなく、検出と除去手法(IPフィルタ、重複検出、CAPTCHA、ベイズ的異常検出など)も示すと良い。

4. 定量的比較の提示不足

- 補足:確率標本での典型的な誤差水準(例:n=1000 → MOE ≈ ±3.1%)を示すと読者理解が深まる(以下で数値を示します)。

4) 定量的補足(逐次計算を含む)

(注:以下は二項割合 p=0.5(最悪ケース)での 95% 信頼区間の概算。数値は逐次計算します。)

n = 1,000 のとき(確率標本を仮定)

1. p(1-p) = 0.5 × 0.5 = 0.25.

2. 分散の標本分母:0.25 ÷ 1000 = 0.00025.

3. 標準誤差(SE) = √0.00025 = 0.0158113883…(小数点以下逐次).

4. 95% 信頼係数 = 1.96。したがって MOE = 1.96 × 0.0158113883… = 0.030994 (約 0.030994 = 3.0994%)。

→ 結果:約 ±3.10%。

n = 100,000 のとき(確率標本を仮定)

1. 0.25 ÷ 100000 = 0.0000025.

2. SE = √0.0000025 = 0.00158113883….

3. MOE = 1.96 × 0.00158113883… = 0.00309944 (約 0.309944%).

→ 結果:約 ±0.31%。

- [注:「無作為抽出でも当然サンプル数を増やすほど精度は高まるけど、無作為抽出ならあまり数を増やさなくても実用上十分な精度が得られる」のそろばん的裏付けの話。]

- [最も理想的に無作為抽出できたシナリオ下では抽出した成分が全体のそれと一致するため、「よく振ったペットボトル飲料を一口分取り出して全体の中身を推測する」みたいな喩え方が可能。この理想形vs実際に採集できたサンプル間に生じうるズレが誤差。]

重要な注記:これらのMOEは確率抽出が成立する場合のみ有効。非確率(SNSの自己選択)では「このMOEは無意味」であり、系統誤差が支配する。

さらに、**重み付けや設計効果(design effect, deff)**を考慮すると、実効標本サイズが減り MOE は増加する。たとえば deff = 2 なら MOE は √2 倍になる(≈1.414倍)。

5) 実務的・政策的含意(何をどう伝えるべきか)

1. 必ず「抽出方法」「調査時点」「回答率」「重み付け手順」「質問文」などのメタデータを確認させること。これらが公開されていない調査は信頼できない。

2. SNSアンケートの「用途」を明確にすること。方向性や関心度、キャンペーン反応の測定には有用だが、母集団の代表推定には慎重さが必要。

3. 三角測量(triangulation)を推奨:確率標本調査、非確率大規模サンプル、行政データ等を組合せる。相互照合で信頼度が上がる。

4. 透明性の要求:統計的推定を行う場合、用いたモデルと仮定(例えばMRPやpropensity model)の詳細を添付すべき。

6) 文章上の改善提案(元解説への具体的修正案)

- 「1000票 vs 10万票」は読者にわかりやすい切り口だが、必ず次の一文を添えるべき:

「ここで言う『1000票』が有用であるのは、抽出が確率的に行われ、標本フレームが母集団を代表している場合に限る。対してSNSの10万票は大規模でも自己選択やプラットフォーム偏りの影響を受けるため、そのまま母集団の推定には使えないことが多い。」

- 1936年・1948年の記述に「総誤差(Total Survey Error)*2」を短く注記すると、読者は以後の議論を制度的に理解しやすくなる。

- “SNSで繰り返し騙されないために” の章に**チェックリスト(抽出方法、回答率、重み付け、質問文、時期)**を明示して実用性を上げる。

7) 最終評価(短評)

元の三回分は概念的に正しく、読者導入として良いが、専門的精度を求めるなら**(A)確率 vs 非確率の定義と適用条件の明確化、(B)Total Survey Error の導入、(C)非確率サンプルを使う場合の統計的補正とその限界の説明、(D)定量例(MOE等)の提示**が不可欠です。特に非確率データの活用可能性については「完全な無価値」ではない点を補足してバランスを取るべきです。

必要でしたら、元文の各回を**修正版(専門家向けの短縮版+読者向け一行要約)**として再執筆します。どの程度詳細に直すか指示ください(数式レベルでの補足、あるいは実務チェックリスト追加など)。

使用モデル(推定):GPT-5 Thinking mini

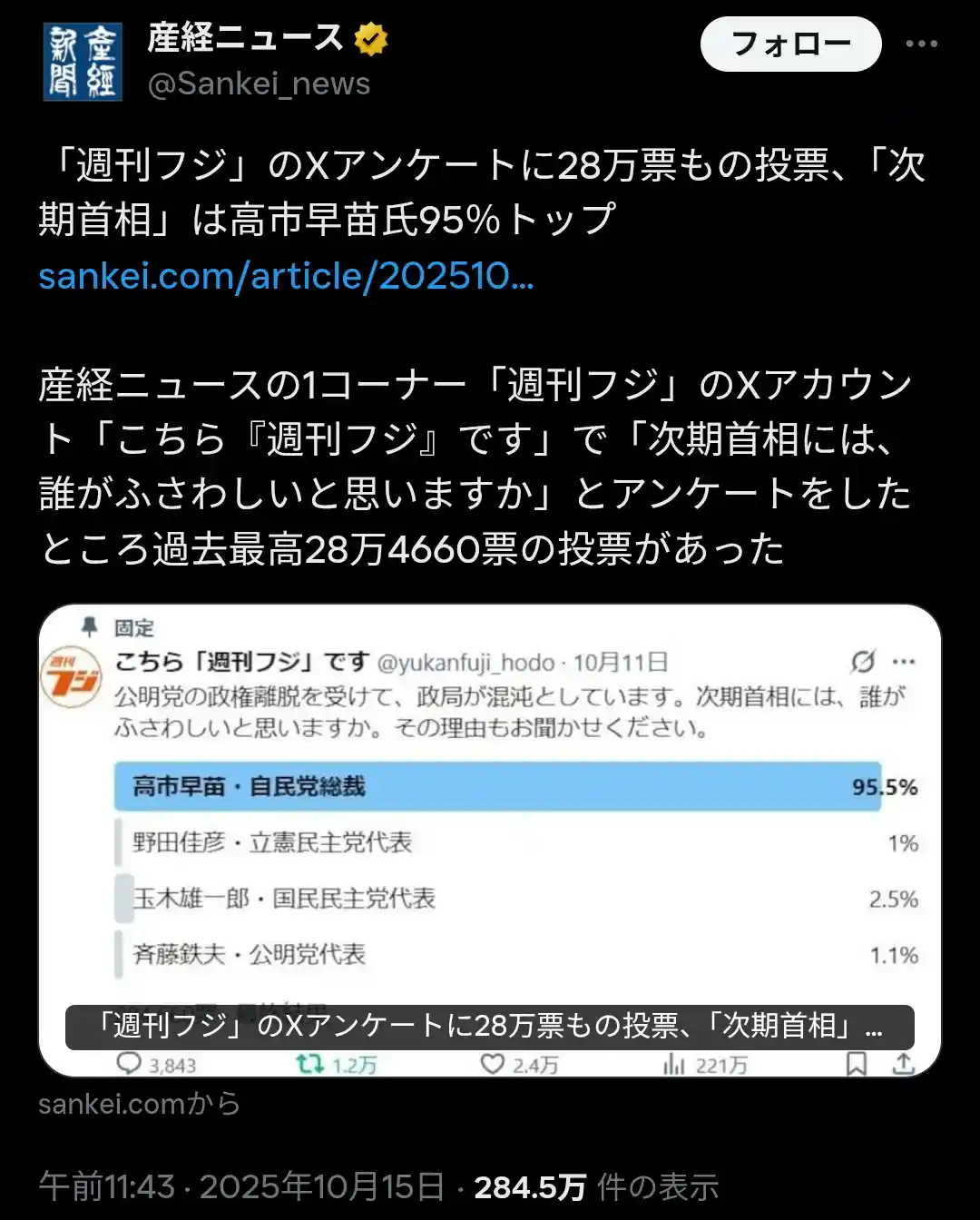

🆕(参考)SNSアンケートで記事書くバイラルメディアの例

- 良い子は真似してはいけません