- 質問をする前に

- とてもよくある質問

- ツール選び

- 始めたばかりの人向け

- プロンプト・呪文関連

- 用語的にプロンプトと呪文ってどっちが正しいの?

- その画像の呪文教えて

- 埋め込み情報を残したままモザイク修正かける方法ないかな?

- 同じ呪文を唱えてもみんなと違う画像が出るのはなぜ?

- どんな呪文を唱えたらいいの?

- 表情とかどう指定すればいいの?

- 呪文の () と {} って何が違うのさ?

- 呪文の中に \(hogehoge\) とか ¥(hogehoge¥) とかあるのって何?

- 呪文の順序って意味ある?

- 呪文に使う半角スペースとアンダーバーってどっちがいい?

- 他の人のネガティブにEasyNegative, って入ってるけどこれ何?

- 特定の行為をするように呪文を入れてもなかなかしてくれません…

- 他の人の呪文にあるBREAKって何?

- 色移りして困っちゃう

- 複数人を登場させる際に要素が混じっちゃう

- 絵師の名前を使わずに画風や絵柄の調整ってできないの?

- プロンプトは英語の自然文で入力したほうがいい?

- 基本的なパラメータ

- モデル・VAE

- 画像生成

- 拡張機能

- その他

- 1111特有の話題

- 1111更新によるUIの変化

- LoRA(画像生成編)

質問をする前に

- まずは出てきた言葉で調べてみましょう。

- 参考:よく見る用語集

- 今見てるページ(よくある質問)内で検索しましょう。

- としあき達はエスパーではないので、曖昧・あやふや・雑な質問には回答しませんできません。

- ツール名(または生成サービス名やURL)を書きましょう。

- ローカル版1111/Colab1111/Nemu先生/Dezgo/PixAI…等

- あと再起動をするとなんか解決することもあるよ。

- 誰に質問するかも吟味してみましょう。

- すぐに回答して欲しい。

→人工知能板@ふたば

http://dec.2chan.net/85/futaba.htm

すでに質問スレが立っていれば、そっちを当たってみておくれ。

なければ、自分で立てる - 的確なフィードバックが欲しい

→GitHubのdiscussionsページ等で議論する

例:https://github.com/AUTOMATIC1111/stable-diffusion-webui/discussions

- 本wikiへ質問する場合は「ひろば」ページがおすすめ。

常駐メンバーは少ないので、あまり期待しないでね。 - としあきホットライン

- すぐに回答して欲しい。

注意

- 画像生成AIプログラム各種はまだ発展途上で、連日機能改善やバグFixを繰り返しています。

- あなたが遭遇するエラーは、多くのとしあきにとって未経験です。「同じ経験はありませんか?」は反応しにくい質問です*1。

- したがって、説明の手間はかかると思いますが、詳しい状況説明が必要なのです。

画像に関する質問

- 自作のAI画像を添付しましょう。AI絵は基本的に生成時の呪文やパラメータが画像内に埋め込まれる仕組みだからです。より良い回答やアドバイスを得やすくなります。

ただし画像編集ソフト等でモザイク修正をかけると埋め込み情報が失われてしまうので、質問内容によりますが健全絵を添付して質問したほうが無難です。 - 実際の画像とメタデータなしに「ぼやける・崩れる・画質がどうこう」と質問するのは、「エスパーしてくれ」というお願いと同義なので、やめましょう。

エラーに関する質問

- まずは表示されたエラーメッセージを日本語翻訳にかけてよく読んでみましょう。

- 元の英文のエラーメッセージでGoogle検索しましょう。

- 誘導→エラー解決メモの各ページ

- エラーに関して質問する場合は、必ずエラー画面のスクリーンショットを投稿する(推奨)もしくはエラー文のコピー書いてね。

としあきが「ここがエラー文だ」と思っている箇所の前後にも、重要な情報が表示されている場合が多いからです。

Windows+Shift+Sで範囲選択してスクショを撮れるよ。エラー内容を書かずに質問しても回答が難しいです。

PCスペックに関する質問

- デスクトップPCかノートPCか、また、グラボとVRAM容量を書きましょう(例: デスクトップPC、3060(12GB))

- また、質問時にはPCやパーツが既に手元にある話なのか、購入を検討している話なのかを明記しましょう。

- 誘導→PCスペック

質問テンプレ

- いつ、何をしようとして、エラーに遭遇したのか。

- 最新Ver.で解決済みの問題もあるので、Ver.は大事。

- 理想の状態は何か?

- 無視できるエラーもある。実害が何かを提示すると対処しやすくなる。

- エラー解決のために、具体的に何をしたのか。

- ログ一覧

- コマンド入力一覧

- 画像生成結果

- エラー発生原因として思い当たることは?通常と異なる何かをした?

画像生成AIも急速に進化を重ねて初心者でも扱えるようになりましたが

まだまだ導入やエラーに悩まされる機会は多いため、問題を解決するためには自分で調べることも大切です。

不適切なコメントを見かけた方へ

- wikiは皆様からの情報を蓄積していくものです。

その一つ一つの積み上げを大切にしています。 - コメント欄は有限であり、申し訳ないですが今後のページ容量のことも配慮しないといけません。

愚痴を見かけたら黙delで良いです。

とてもよくある質問

しばらくスレを覗いてなかったけど何か新しい動きあった?

誘導→最近の主な出来事

久しぶりに1111を更新したらエラーが出る

- 久しぶりの場合まず更新するのは一度止めておきましょう。

- 様子を見て更新したい場合は新しいフォルダにgit cloneする方が良いです。

誘導→ローカル版更新#既存データを残しつつ、任意ディレクトリで新規構築する- 表示されたエラーメッセージの内容で検索してみる

- venvフォルダとrepositoriesフォルダを削除してから起動を試す

等

僕もお絵描きAIを使えば貼られてるようなエッチな画像を作れますか?

簡単に作れます。まずは無料ツールで体験してみましょう。

物足りなくなってきたりニッチな性癖を出したい場合は有料サービスや自分のPCにローカル環境構築すると良いでしょう

SDXLは高スペックPCじゃないと使えない?

ComfyUIやForge(該当ページ参照)の登場によりVRAM使用量を抑えることが可能になったため

VRAMが8GB程のグラボ搭載ゲーミングPCでもSDXLを楽しめるようになりました。

是非実際にお試しください。

SDXL系列モデルの利用時に色がおかしくなる

それはSDXL系列モデルに、SD1.5系列用のVAEを適用してしまっているからです。

誘導→SDXLモデル#SDXL系列モデルの導入

基本的にはモデルに内蔵されているVAEを利用すれば十分なので、Noneを指定してください。

他にSDXL 1.0標準の物や、Civitai等で配布されているXL系列用VAEも存在します。お好み次第でそれらを利用しても構いません。

ツール選び

AI絵の生成Webサービスとローカル環境構築、どっちがいいの?

本Wikiがオススメするのはローカル環境の構築です。本Wiki自体、ローカル生成者向けの情報を多く取り扱っています。

体験ツール/Webサービス

要求されるPCスペックが低く、大半のサービスがスマホやタブレットからの利用にも対応しています。

これからAI絵を始めたい人、PCを持ってない人やPCスペックに自信がない人におすすめです。

最近は学習ファイルを使用可能なサービスが増えてきました。Dezgo、PixAI、SeaArt等。

モデルの使用、大きな画像サイズの生成、クオリティアップをする場合はトークン性で制限がかかる場合が多いです。

また突然の仕様変更・規約変更・サービス終了などの可能性もあるため、過信するには注意が必要です。

ローカル環境構築

✔ 生成が無制限(一度環境構築してしまえば何枚でも無限に生成可能)

✔ 表現規制なし(マニアックな絵でも出力し放題)

✔ サービス終了の心配がない(バックアップを取っていれば新PC移行しても半永久的に再構築可能)

✔ 大量に生成する場合はWebサービスより安価になる

✔ 学習ファイルの作成が可能

❌ ある程度の性能を満たしたPCが必要

❌ Webサービスに比べて導入難易度が高い

ローカル環境の構築には数多くのメリットがあります。既にPCを持っているのであれば、ぜひ検討してみてください。

低スペPCでもできる、またはPCが無くてもできるのはどれ?

- まずは体験版リンクをどうぞ。基本的に無料(一部課金制のサイトも存在)、かつインストール不要。

スマホやタブレット等のモバイル環境に対応してるものも数多くあり、ブラウザから操作できます。

またクラウドで動作する仕組みなので、PCの性能に自信がない方にもおすすめです。

短所は時間帯によっては順番待ちが長くなることと、無料版ゆえに画像サイズやモデル選択等の機能が制限されていることです。 - 若干の努力を必要としますが、ColabでStable Diffusion web UIを動かすこともできます。Googleのサーバを借りて遠隔操作する形になります(時間貸し有料)。

始めたばかりの人向け

画像が作れない

まずは「何の画像も出てこない」「真っ黒やぐちゃぐちゃだったりして生成できてるとは思えない」など、どういう状況なのかを区別しよう

何の画像も出ない

エラーが起きている可能性が高い。使っているツールとエラーメッセージをチェックして調べよう。

頻出エラーならwikiにも対策が掲載されている場合もあるし、エラーメッセージでそのままグーグル検索したり、あるいはChatGPTなどのAIに質問しても答えが見つかることがある。

それでもわからなかったら、ツールとエラーメッセージを添えて質問してみよう。

真っ黒な画像が出た

誘導→エラー解決メモ#A tensor with all NaNs was produced in VAE.

まともな画像が出ない

ケースバイケースだが、まずはこのページを一通りチェックしてみよう。

プロンプトやパラメータ、サンプラーやステップ数を調整することで解決するかもしれないので試してみよう。

また、学習ファイルを使う場合、学習ファイルの適用方法が間違っていたり、あるいは学習ファイル同士が干渉してたり、そもそもきれいに学習できていない失敗作の学習ファイルを使っているのかもしれない。

学習ファイルを外してどのように画像が生成されるかも確認しよう。

大きなサイズの画像を出したい

- Stable Diffusion web UIやNMKDで出せるサイズは、グラボのVRAM次第。

また、大きなサイズを出そうとすると生成時間も劇的に長くなる。

人体の崩れ、頼んでないのに2人以上になる、等の問題も増加する。

こちらも参照→よくある質問#大きな画像生成についてもっと教えて?

版権キャラを出すにはどれがオススメ?

メジャーなキャラ、かつ、ひと昔前の流行りなら、体験版リンクやNovelAIでも出せるかもしれません。

マイナーキャラや最新すぎるキャラの場合には、自分で学習させる必要があります。もしくは有志が学習データを作成し配布している可能性もあります。

ただし自分で学習させるにせよ、有志の学習データを利用するにせよ、1111もしくはNMKDが必要になりますので、ローカルorレンタルGPUを検討してください。

出しやすい・再現しやすい版権キャラっている?

例を一部挙げるとミクさん・チノちゃん・アスカ・めぐみんとか。他にもいっぱいいる。

ひどく大雑把に言うと、人気の高さやファンアートの数。より正確に言うならモデルがそのキャラをどれだけ学習してるか、の影響が大きい。

Danbooruのキャラ名タグの数 もある程度は参考になる。

もある程度は参考になる。

しかしDanbooruから学習したモデルとは限らないし、実際に例外が多数確認されている。

簡単に出ないなら、まずは髪型・髪色・衣装・アクセなどの指定を組み合わせて可能な限り寄せてみよう。

キャラ名だけで簡単に出るとしても、指定を増やすことで打率がさらに高くなる。ただし限界はある。またプロンプトをあまり長くしすぎると今度は弊害の方が大きくなる。

身も蓋もないことを言えば、「再現できなければ自分で学習させて個人で楽しむ」、それが可憐な乙女のポリシー。

こんな方法もあります:

- Danbooruでそのキャラによく使われているタグを調べ、それをプロンプトに利用する

- DeepDanbooru

に画像を読み込ませることで、画像の内容からタグを提案させる

に画像を読み込ませることで、画像の内容からタグを提案させる

先週よりいい画像ばかりだから勝手に学習したんだね

NO。現在の画像生成AIには、自動的に学習する機能はありません。

また、ユーザーが入力した呪文や生成結果の画像によって自動的に学習していくということもありません。

恐らくはユーザー自身がAI絵の知識とコツを蓄積したり、目的に合った呪文を見つけたことによって良い画像になっただけでしょう。

1111やNMKDには学習機能も用意されていますが、ユーザーがそれを意図的に利用しない限り、勝手に学習を開始してくれることはありません。

最新のグラボに買い替えたんだけど以前と生成速度が速くならない

がっかりするのはまだ早い。下記の項目を上から順に確認してみよう。

- (RTX 40xxの場合) torch: 2.0.1+cu118にする。torch: 1.xはRTX40xx用に最適化されておらず、半分程度の速度しか発揮できないため

誘導→Xformersを導入する#Pytorchのアップグレード - グラボのドライバを最新にする

- マザボのドライバ、ファームウェアを最新にする(意外と盲点)

- stable-diffusion-webuiフォルダ内のvenvを削除して再構築する ※バックアップはとっておくこと

誘導→venv

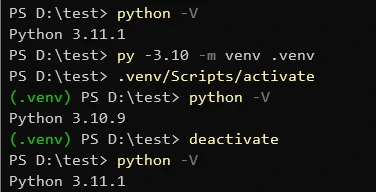

Pythonのバージョンは何が良い?○○だと駄目なの?

- Python3.8未満および3.11以上のバージョンは使用しないでください。

Stable Diffusion web UIが対応していないバージョンです。

- 推奨バージョンはPython 3.10.6です。開発者もそのバージョンで動作確認を行っているはずなので、ローカルに環境を作る場合はバージョンを合わせておいた方が無難です。

なお、ColabやPaperspaceのようなオンラインサービスの環境では3.9がインストールされているのをそのまま使う場合がありますが、別にバージョンをぴったり合わせなくても動くのでそれほど心配する必要はありません。3.8~3.10を使っている限り、エラーが起きてもPythonのバージョンが原因である可能性は低いです。

- Python 3.10.10でStable Diffusion web UI v1.5.1及び主要な拡張機能群が正常動作していることを確認しました(2023/8/27)

AI以外で既にPython3.11を使ってるんだけど

3.11はそのまま3.10を追加でインストールして、venv(Pythonによる仮想環境)を使用することで特定のフォルダ内でのみ3.10を使用することができます。

3.10の追加インストール後、コマンドプロンプトでSDやLoRAを配置したフォルダへ移動し

py -3.10 -m venv venvと入力することで仮想環境が作成されます。

作成した仮想環境に入るためには同じフォルダで次のように入力します。

venv/Scripts/activate仮想環境に入ることができれば、コマンドプロンプト左側に(venv)と表示されます。また、Python -Vで3.10が動いていることを確認できます。

この状態でSDやLoRAのインストール・実行を行いましょう。

また、次のコマンドによって仮想環境から出ることができます。

deactivate一度終了後再びSD等を実行したい場合は再度venv/Scripts/activateで仮想環境に入りなおす必要があります。

エッチ画像がなんか(エッチじゃない意味で)ものすごいことになるんですが

困ったことに、現在のStable Diffusionは人体同士がくっついたり重なったり一部をどうこうしたりする絵の生成があまり得意ではありません。

(エロ画像の失敗ばかり取沙汰されますが、普通に肩組んだり抱き合ったりするのもわりとなんかおかしいのでどうしようもないです)

いろいろ小細工の方法はあるんですが、それでも単純なソロヌード絵以外のヒット率は5割くらいだと思われます(生成バリエーションを犠牲にすると上がる)。

できちゃった(大量の)ヘンテコ画像は…へたくそAI画像選手権にでも出すしかないんじゃないでしょうか。

ポーズだけはとてもイイというような場合はControlNetの素材用に保存しておくという手もありますが、でもたぶん使わないです。

プロンプト・呪文関連

用語的にプロンプトと呪文ってどっちが正しいの?

呪文よりもプロンプト(Prompt)のほうが正しいんですが、プロンプトもあまり正しくはないです。

(ワークフロー上でユーザーの入力を示す用語であって、具体的な入力文字列そのものを指す言葉ではなかった)

用語としては呪文という言葉はかなり古く、画像生成が誰にとってもナゾだった、まるで魔法みたいだった時期のものです。

2024年現在ではプロンプトという用語のほうがマトモな解説に辿りつきやすいので、プロンプトと覚えたほうがいい、かもしれません。

その画像の呪文教えて

- スレを閲覧する際はとしあき製のブックマークレットを利用するのがオススメです。

それぞれレスの下に、画像の埋め込み情報を表示してくれます。

ただしNMKDから生成した画像のメタデータには未対応となります。 - 1111ならPNG Infoのタブに画像をドラッグ&ドロップすると幸せになれます

- もしくは以下のような画像のメタデータを閲覧できるサイトで確認できます。

https://image-convert.cman.jp/imgInfo/

https://novelai-metadata-viewer.pages.dev/

呪文が出ない場合、モザイク処理などの都合で消えていることあります。

いい呪文を唱えた人に敬意を持ち、直接聞いてみましょう。

他にも、後述する拡張機能のImage Browserは自分が生成した画像を一覧表示して、それぞれの画像をクリックすると生成時の情報を表示してくれます。

削除を押さないように注意。

埋め込み情報を残したままモザイク修正かける方法ないかな?

![]() としあき製のモザイクツール(2024/04/09版)を使うと、メタデータを保持したままモザイク処理を適用できるよ。

としあき製のモザイクツール(2024/04/09版)を使うと、メタデータを保持したままモザイク処理を適用できるよ。

(2023/08/08)

画像フォルダドラッグ時に.webp形式も開けるように対応。

カンバスをウィンドウサイズに合わせてリサイズするように変更。

マウスチルトでカンバスの水平スクロールに対応。

モザイク中を追加。

モザイクサイズとグリッド吸着サイズを同期化(モザイク大を重ねがけしたときにグリッドがズレてぐちゃぐちゃにならないようにする為)

処理中のファイル名をウィンドウタイトルに表示。

その他バグ修正等。

ついでに python環境なしでも使えるようにpyinstallerでEXE化。EXE版はサイズが大きので外部にアップロード

としあき製のモザイクツール(2023/05/13版)

フォルダをドラッグアンドドロップしてフォルダ内のファイルを連続でモザイクしていけるよ。さらに[CTRL]+[Z]キーでアンドゥもできるよ。

(2023/05/13)

元の作者や改良してくれた人とはさらに別のとしあきなんだけど、フォルダ内の大量画像を連続してモザイクしていけるようにフォルダ指定モードを追加したよ。

mosaic.batにフォルダをドラッグアンドドロップして使ってね。[CTRL]+[N]キー or [→]キーで次の画像ファイルへ進み、[CTRL]+[B]キー or [←]キーで前の画像ファイルへ戻れるよ。

あと、[CTRL]+[Z]キーでモザイク処理をアンドゥできる機能も追加しといたよ。pythonを知らないエンジニアがchatGPTさんに教えてもらいながら改造したのでバグってたらゴメンね。

としあき製のモザイクツール(2023/04/08版)

マウスを右クリックする度にモード変更(モザイク大/モザイク小/ぼかし/黒塗り)

(2023/04/08)

wikiに貼られてた「としあき製のモザイクツール」をちょっと改良してみました。一言でいうと事前準備が不要になり、余計なフォルダを汚さないようになりました。

(2023/01/31)

元の作者とは別のとしあきなんだけど

モザイクの範囲指定にグリッド吸着を入れたかったので改造してみました

(2023/01/24)

mosaic.txtをmosaic.batにしてダブルクリックで起動するだけよ

もし一瞬で閉じて起動しなかった場合はPILっていうPythonの追加モジュールがはいってないとおもうからコマンドプロンプトから

pip install pillow

ってやってモジュールいれるだけ怖くないよ

(追記: 04/08 版でこの作業は不要になっています)

なお、一般的なローカル1111民の環境を想定に用意されたものなので、

1111をワンタッチ導入した人や、NMKD民、NovelAI民などの人には、Python 3.10のインストールも必要になるようだ。

その方法については、ローカル版導入のページにある「2. Python 3.10をインストールする」の部分を参考にしてほしい。

(追記:としあき製のモザイクツール(2023/08/08版)のEXE版 で、Python環境がなくても使用できるようになりました。Windowsのみ。)

で、Python環境がなくても使用できるようになりました。Windowsのみ。)

同じ呪文を唱えてもみんなと違う画像が出るのはなぜ?

- モデルや学習データやその他細かい設定の適用などで違う可能性があります。

- 全然違う画像が出ている場合はモデルが違う場合がほとんどだと思いますので、貼られている画像のModel hash:の部分を確認しましょう。

モデルマージという機能(調合のようなもの)でマージモデルを自作している人もいます。 - もしくは、文章から画像の生成ではなく、画像から画像の生成(img2img)をしている場合があります。

- 設定項目はt2i,i2iタブだけでなく、Settingsにも多数あります。そちらもチェックしましょう。

- 使用しているライブラリのバージョンが違う場合があります。

torch等が一例ですが……アプリの安定性に影響を与えるので、そこまでして同一Ver.にこだわる必要はないでしょう。

どんな呪文を唱えたらいいの?

https://magic-generator.herokuapp.com/ などを使用するか、他人様の呪文を参考にしましょう。

などを使用するか、他人様の呪文を参考にしましょう。

もしくは「〇〇 danbooru」などで検索してもいいかもしれません。 例)「口内射精 danbooru」

ここの呪文コーナーのリンクを確認してもいいかもしれません。

表情とかどう指定すればいいの?

https://rentry.org/faces-faces-faces を参照

を参照

ここの呪文コーナーのリンクを確認してもいいかもしれません。

呪文の () と {} って何が違うのさ?

としあきがAI絵の生成に使ってるツールも色々ある。そしてツールによって強弱の構文が異なるのだ。

例えば1111では () が強調1.1倍。

NovelAIでは {} が強調1.05倍。

1111やNovelAIでは重ねて使うと乗算になる。例えば (()) は1.21倍。

1111の強調構文ルールは、誘導→ 特殊なPrompt指定

- Dezgo (https://dezgo.com/)

(参考) https://rapidapi.com/dezgo/api/dezgo/tutorials/prompt-weighting-(attention-%2F-emphasis)

(参考) https://rapidapi.com/dezgo/api/dezgo/tutorials/prompt-weighting-(attention-%2F-emphasis)例 (masterpiece)1.2, 例 (masterpiece)++,

- NovelAI

(参考) https://docs.novelai.net/image/strengthening-weakening.html

例 {{{{masterpiece}}}},

- 1111

(参考) https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Features#attentionemphasis

例 (masterpiece:1.2), 例 ((masterpiece)),

- どちらかというと前者の書き方がおすすめ。後者は強弱を調整する際に、前後のカッコ数を一致させるのが面倒なので。

- Ctrl+↑↓で強弱の値を変更することもできるよ。

- camenduru先生のやつも1111と同様。

- NMKD

(参考) https://github.com/n00mkrad/text2image-gui/blob/main/README.md#features-and-how-to-use-them

例 (masterpiece)1.2, 例 (masterpiece)++,

呪文の中に \(hogehoge\) とか ¥(hogehoge¥) とかあるのって何?

呪文の順序って意味ある?

ある。先頭に近いほど効きやすいとか、距離が互いに近い単語同士は影響を受けやすい(色移りもしやすい)、とか。

(参考) PART3 -プロンプトの工夫で指定色が混ざるのを防ぐ方法- - Defblog(デフブログ)

もっとも、後ろの方でも十分効きやすい単語もあるし、強調構文(下記参照)で調整する方法もある。

誘導→呪文の () と {} って何が違うのさ?

呪文に使う半角スペースとアンダーバーってどっちがいい?

基本的に半角スペース。例: upper body, hair ribbon,

なぜなら現在のモデルの大半が半角スペースを使った単語で学習しているから

(逆に言うと、初期にはアンダーバーを用いた素のdanbooru語で学習していたモデルもあった)。

また現在でも半角スペースではなくハイフンで繋ぐ形の単語が一部に存在する。例: see-through, one-piece swimsuit,

ともあれ、1111を利用している場合は拡張機能Booru tag autocompletionを導入してオートコンプリート機能を利用するのが手っ取り早い。

他の人のネガティブにEasyNegative, って入ってるけどこれ何?

その単語は通常のネガティブではない。有名なネガティブTIの名称だね。該当するファイル名のTIの効果を得るために書いてあるんだ。

DezgoやNovelAIでは、それを真似てEasyNegative, とか入力しても同じ効果は得られない。

配布元から対象のファイルをDLして、1111とかで指定の場所に導入。

その上でプロンプトやネガティブにファイル名を書く(Textual Inversionタブから選んでも良い)。

この手順を踏むことで初めて効果を発揮する。

主なネガティブTI

誘導→配布物/Textual Inversion

TIなので stable-diffusion-webui\embeddings に突っ込んでTextual Inversionタブから利用する。

ただしネガティブTIだから、プロンプト欄ではなくネガティブ欄に挿入しよう。

画風への影響も強いので強弱を調整して使うことも検討してほしい。

どんどん併用すればするほどいい…ってものでもない。

例えばInpaintで手指ガチャする時だけbad_promptを利用する人もいる。

(参考) bad_promptを作った人による、ネガティブTI製作手法のメモ

https://www.reddit.com/r/StableDiffusion/comments/yy2i5a/i_created_a_negative_embedding_textual_inversion/

特定の行為をするように呪文を入れてもなかなかしてくれません…

モデルによって表現に得意不得意があります。

Civitai 等に特定の行為に特化したモデルがあるので、普段使っているモデルとマージして新しいモデルを作るのもいいかもしれません。

等に特定の行為に特化したモデルがあるので、普段使っているモデルとマージして新しいモデルを作るのもいいかもしれません。

誘導→Checkpoint Merger

誘導→モデル紹介#その他

あと、意外と盲点なのが「モデルに収録されたタグの使い方とプロンプトの指定が異なっている」パターンです。

「普通に考えてエッチな行為なんだから😺は必要だろう」と思って😺と書いたが、実は

「😺の大部分がつつがなく見えてるときのみ😺タグをつけ、つつがある等で全体が視認しにくい状態のときは😺タグはつけない」

のようなルールがある、といったことがあります(特にイラスト系)。

どうもおかしいな、と思ったときは収録タグや日常的に何の気なく使っているプロンプトの使われ方を調べてみると役に立つかもしれません。

他の人の呪文にあるBREAKって何?

※リンク先のページは、Stable Diffusion web UI向けのページです。

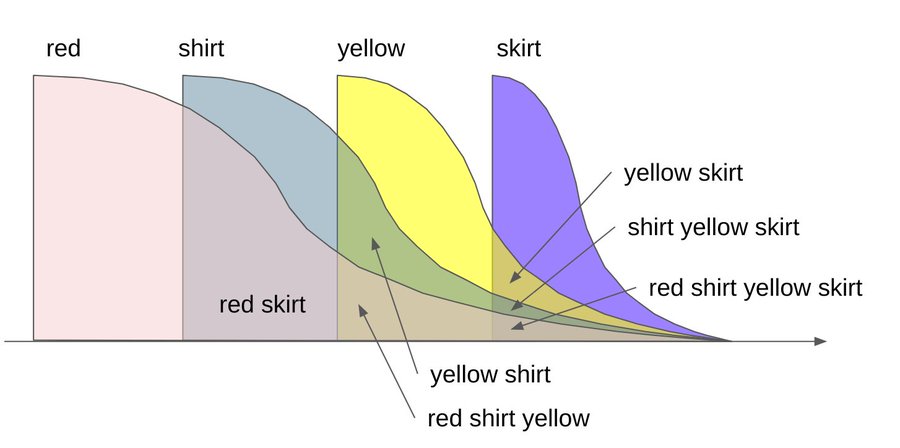

色移りして困っちゃう

例えばblue shirt, red skirt, black ribbon, と指定していても、

青いシャツ、青いスカートと黒いリボンが出力されたり、

青いシャツ、赤いスカートと赤いリボンが出力されてしまうことがしばしばある。

- 憶えておきたいこと

- それらを踏まえたコツ

- それぞれの強弱を調整する。

- プロンプト内の順序を入れ替える。異なる色の表現を隣接させない。

間に他の単語が入るようにする。同じ色同士は近くにまとめる。

(例) blue shirt, 1girl, solo, smile, red skirt, - 半角カンマ(,)をいくつか挿入するのも有効かもしれない。カンマも1トークンとして扱われるからだ。

(例) blue shirt,,,,, red skirt,,,,,,black ribbon,

ただし1111のプロンプト欄に表示されるトークン数の値は、仕様や不具合などの理由により必ずしも正確でない場合がある。 - 間にBREAK構文を利用する。

- 拡張機能Cutoffを利用する。

誘導→Extensions#Cutoff

複数人を登場させる際に要素が混じっちゃう

- 拡張機能Regional Prompterを利用する

誘導→Extensions#Regional Prompter - 1人目と2人目の間にBREAK構文を利用する

- Inpaintを利用して一人ずつ調整する

絵師の名前を使わずに画風や絵柄の調整ってできないの?

現時点では残念ながらできない。

「もっとジブリ風にして欲しい」ときにジブリ関係者名を使わずになんと表現すればよいかわからない問題

を解決できるまではどうしようもない。

…つまり、既存の取り込みイラストデータに画風や絵柄の説明がそもそも全くついていないために、「○○な感じの絵」と指定しても該当の画風や絵柄に辿りつけないのである。そのかわりに「○○な感じの絵」を描くイラスト作成者の名前を指定すると、その人が描いた絵を通して「○○な感じの絵」の群に結果的に辿りつける。人が欲しいわけではないはずなのだが、現状では人の名前を辿っていくしかない状況となっている。

理想としては、欲しい出力を人間側が詳細に文章で説明できるべきである。しかし、肝心の人間側に絵や芸術に関する説明用の語彙が全くない。仮に今からデータベースを作り直したとしても、そのタグを他の人も思いつくかどうかという表現語彙妥当性の問題が別途発生してしまう。

by絵師名プロンプトや絵師LoRAは人類の敗北の産物といえる。

なお、人間がキーボード使ってプロンプトに希望を文章入力する行為自体が過渡期の産物と言えなくもないので、将来的には別方向からなんとかなるかもしれない。

プロンプトは英語の自然文で入力したほうがいい?

A1111系列のローカル生成のプロンプトにおいては、

「英文で入力すると再現度が上がるが、英文をAI的に翻訳理解した結果ではないので、単語やフレーズで入力してもよい」

が、今のところの結論です。他のウェブサービスでは別の補助が入っている可能性があります。

要は

「文の終わりに近いところの内容は比較的どうでもよい(大事な言いたいことは前側に)」「空白で要素が区切られる」

「コンマでの並列化は空白より強い」「ピリオドはコンマよりもさらに強い ※つまり1文の終わり」

…という一般的な英語の文章の理屈が、画像生成の要望吸い上げシステムとして採用されているというだけの話です。

あなたが英語ネイティブならわざわざ英単語ぶつ切りで考えるよりも英文で入力したほうがやりやすいはずですが、

ネイティブでないなら希望要素を英単語や熟語で表現し、空白・コンマ(とピリオド)で区切って優先度順に並べたほうがやりやすいかと思われます。

(「この文章だと○○が伝わってないようだから書き換え/並べ換えしよう」ってできませんよね。単語だけでいいです)

基本的なパラメータ

Seedって何?

誘導→Seed

step数はどれくらいがいい?

「低いstep数でもイイ画像が出る特殊なサンプラーor特殊なモデルです」というものでない限り、基本は20。

ただし、プロンプトが長い・キャンバスが広い・背景や精細が自慢のモデルである等の理由で「描くべきもの」が多い場合、

step数が20のままだと描き切れないことがよくある。

モデルの製作者が「stepは30以上でオナシャス」と言っていたら、生成時間が伸びるけど素直に30を指定しよう。

sampler(サンプラー)はどれがいいの? (txt2img/img2img)

🐍(訳: わからん…それは人それぞれ違うからだ。)

優劣をつけるのは難しいが、特徴はあるので、好みで選ぼう。

- スレ民の印象は、だいたいこんな感じでした。(2023/8月頃)

- 高速安定 → Euler a

- 高画質 → SDE karras系

- なにか物足りない → それ以外

- ざっくり経緯として、

Euler aが結構初期(2022年頃)からあるのに対し、

SDE karras系は様々な派生Ver.があり、2023/8月にも新たなsamplerが登場している。

一応、SDXL系列のモデルでは、Euler aが推奨されることが多い……が、やはり好みの問題もある。

参考ページ

(1111)Clip skipの値はいくつがオススメ?

誘導→Clip skip

モデル・VAE

- モデルってなんですか?

- おすすめのモデルはどれ?

誘導→モデル紹介

- 拡張子が色々あるけど、どれを選べば良いの?

- 同じモデルでも複数(fp16,fp32,pruned)あるけどどれがいいの?

- モデルデータをDLしたんだけど、どこに置けばいいの?

- (1111)モデルデータを指定の場所に入れたのにcheckpointリストに表示されない!

- (NMKD)モデルリストに.safetensors形式のモデルが表示されないんだけど?

- モデルデータを軽量化する方法

- 追加のモデルフォルダを指定する/モデルフォルダだけSSDに置く/シンボリックリンクの作成方法

- モデルファイルのトークン破損チェックと修正方法

- 生成した画像の色が薄いんだけど…

- VAEの設定方法がわかんない

誘導→VAE

画像生成

顔面が崩壊して怖い!どうすればいいですか?

基本的にAI絵はその仕組み上、細かな部分の描写が苦手で崩れがち。小さな手、小さな目、小さな顔など。

対策はいくつかある。

- upper body, またはportrait, などの単語を使って上半身にズームした構図にする

- 根本的に画像サイズを大きくする。後述するHires.fixを、数値を調整しながら利用するのがおすすめ

- 実写系の場合は、Restore faces(顔の修復)をONにするのも良いかも。ただし二次絵には向かない

- CFGスケールの数値を下げて呪文の影響を弱める。

- Inpaintで修正する。この時Inpaint area=Only maskedを選択し、pixels=32の値を調整する。数値を上げすぎるとWhole pictureと同じ結果になってしまうので、様子を見ながら上げ下げしてほしい

- 拡張機能Detection Detailerを利用する。左の画像参照。

誘導→Extensions#Detection Detailer

(2023/12) 現在ではadetailerがその後継的な役割を担っている。

誘導→Extensions#adetailer

画像がぼやけるんだけど誰か理由と解決策わかる?

様々な原因が考えられるから必ず画像を貼れ、メタデータ付きのだぞ

エスパーレスすると

- プロンプトもしくはネガティブの数が多すぎる、または強調が強すぎる

断舎離する、強弱を調整する - 過学習、あるいはLoRAの適用強度が強すぎる

<lora:hogehoge:0.5>とかに弱めてみる - (Hires.fixまたはimg2imgを使ってる場合)Denoising strengthの値が小さすぎる

0.55とか0.6とかで試す

手の指が崩れる。どうすればいいですか?

- ネガティブプロンプトやネガティブTIを試す

- 手の部分をInpaintして、上手くいくまで何度も試す

- 小さい部分は潰れがち・崩れがちになるので、Hires.fixやimg2imgで画像サイズを大きくする

- ControlNetのcannyやscribbleを利用して指の線画をAIに提示する

など

暗い画像が作れない!

- StableDiffsionのノイズ画像が明るいので基本的には暗い画像は作りにくいです。

- 下記のような黒いノイズ画像を用意してimg2imgを使って書かせれば暗い雰囲気の画像をつくれます。

- 他にも暗い画像専用LoRAもあります。

(例) https://civitai.com/models/48139/lowra

https://civitai.com/models/221845/lowra-offset-noise

- 拡張機能cd tunerをインストールすることで、生成画像の明るさや彩度をスライダーで調整できます。

https://github.com/hako-mikan/sd-webui-cd-tuner

○○ってモザイク修正要る? ××は? △△は?

ちょっとでも迷ったら全部修正するに限るよ

としあき…としあきや…

迷うくらいならモザイク修正かけておしまい…

ぶっちゃけモザイクって具体的なガイドラインとかなくて全部警察の裁量次第だからなマジで

ヤバそうと思ったら全部修正しとくのが無難

拡張機能

wd14-taggerでExclude tagsにタグを入力しているのに除外されていない

複数単語で構成されているようなタグは元のアンダーバーも入力する

✕ganyu (genshin impact),

〇ganyu_(genshin_impact),

その他

何か良い画像ビューワーない?

としあき達のオススメはIrfanView。

https://forest.watch.impress.co.jp/library/software/irfanview/

AI絵を投稿するのにいいサイトある? 渋以外に

誘導 → AIイラスト投稿可能なサイト

Hires.Fix拡大とかImage to Image修正とかControlNetとかって、やらないとダメなんでしょうか

やらなくていい。

「拡大や修正(を学んだり調整したり)する時間で新しいシードで新しい画像をたくさん生成する」

「Irfanviewなどの画像表示アプリの拡大表示機能で画面一杯にして(たまに腕曲がってるのとか無視して)鑑賞会を開く」

「外部画像編集アプリでガッと切り取ってガッと透過画像にしてちょっと消しゴムかけて印刷して掲示に貼った」

「着衣状態から結果出力ごとにプロンプトを微修正して「ほら!何が欲しい!3文字だ!3文字で言え!」ごっこをする」

それであなたの楽しみや用事が満たされるのなら、それで全く構わないのではないだろうか。

WebUIなどの、より良い生成?とかオモシロ生成?とかができるらしい機能は、求道者向け、平たく言うと趣味の領域である。

なお、エッチ画像大量生成→なんか飽きる→ComfyUIを試す→画像生成フロー自体にハマる といった展開はよくある話らしい。

1111特有の話題

PNG InfoからSend toすると、モデルが自動で切り替わって重いっす

Settings → User interface → Infotext → Disregard checkpoint information~

をONにすると、Send toしてもモデルが自動切り替えされなくなる。

また、v1.7.0現在ではデフォルトでONになっている。

画像の生成をずっと続けるのってどうやるんだっけ

Generate ボタンの上で右クリックしてGenerate foreverを選択。

止めたい時は同様に右クリしてCancel generate foreverを選択し、必要ならInterruptボタンを押す。

注意: Generate foreverを始める前に、Seed=-1 になってることを確認しておくんだぞ…

でないと1ループが終わる度に同じSeed値に巻き戻って、同じ画像が量産されてしまうからな…

あと途中でプロンプトや設定に変更を加えた場合は、次のループから反映されるよ。

知らん間にClip skipの値が1になってた

画像の埋め込み情報にClip skipやENSD(Eta noise seed delta)等も含まれてる。

Send toボタンを押すと、その瞬間に1111の設定が書き換わるので注意。

1111の機能改良により、上書きはされなくなった。

代わりにtxt2imgやimg2imgの左下辺りにOverride settingsとして表示され、一時的に適用される。

Quicksettings listに「CLIP_stop_at_last_layers, 」を書き足すと、画面上部に常時表示されるので、確認が楽。

大きな画像生成についてもっと教えて?

大別すると、以下の4つの方法がある

(a)直出し。普通にwidthとheightを大きく指定する(崩れがち)

単純にVRAMが許す限りの大きなサイズを指定しよう…とはいかない。

Widthを大きくすると複数人が描かれやすくなる。

Heightを大きくすると身体が崩れやすくなる。

これはモデルが学習に使用した画像のサイズによって、モデル毎にサイズの得意・不得意があるからだ。

一般的に768x768くらいまでは破綻が起きにくいが、それよりも大きなサイズを指定すると破綻し易くなる。

破綻を回避しつつ大きなサイズの画像を出力するには、Hires.fix、img2img、Extrasなどの機能を利用すると良い。

とはいえ、打率は低いものの単純な直出しでも上手く生成できることもあり、中にはそれを好む人もいる。

(b)Hires.fixをONにして生成する(精細だけど遅い)

工程を2段階に分けることで構図の破綻を抑えよう…という1111の機能。

まず1段階目は、モデルが得意とするサイズで普通に生成する。

次にその画像に補正をかけつつ拡大する。

さらにその結果を元画像にしてimg2imgを行う。これが2段階目。

描き込みの精細さに人気がある。破綻防止はそこそこ。

Denoising strength(ノイズ除去強度)の値が重要で、小さいほど1段階目に忠実になるが、同時にぼやけがちになる。

値が大きければ精細になるが、元画像からの乖離も大きくなる。

適正値は拡大率や好みによっても変わるが、x1.5~2.0の場合おおよそ0.55~0.6くらいだろうか。

Upscalerは10種類以上あり、どれを選択するかによっても画像の雰囲気が多少変わってくる。

画像の基本的な部分は同じなので、その時の好みに応じて使い分けよう。

参考記事 (現在は更に種類が増えている)

(現在は更に種類が増えている)

(c)元になる画像を、img2imgを使って拡大する(やや遅い)

i2i、稀にいもげいもげとも呼ばれる。

元となる画像を指定する点が、txt2imgとの最大の違い。

AIに具体的な参考画像を与えるので、モデルが不得意とするサイズでも構図が破綻しにくい。

1111のデフォルト設定では、step数を指定よりも多少省く挙動になっているので、Hires.fixよりは高速。

生成中のコマンドプロンプト画面を見ると分かるのだが、steps20等を指定しても、11とか13とか、指定より少ないstep数で計算する仕組みになっている。

おおよそ step数×Denoising strength くらいの値。

いや物足りねーよ、って人はそれを加味して大きめのstep数を入力してもいい。

またSettingsには、指定通りのstep数でi2iさせるためのオプションがある。

Settings → Stable Diffusion → img2img → With img2img, do exactly the amount of steps~

体や背景が見切れている時はどうするといいですか?

「Outpainting mk2」または「Poor man's outpainting」を使用することで、画面外のものを新たに生成できます。

どちらを使うと効果的かは、画像の状態や何をどのように拡大するかによっても変わってきますので、両方試して比べてみましょう。

下半身など見切れている範囲が大きい場合、実写系はInpainting用モデルを使うと体がより綺麗に生成されやすい傾向(二次絵系は未検証)。

ちなみに、SDではなく自分で描いたり撮ったりしたイラストや写真の画像でも有効で、それらを拡大するという応用の仕方もあります。

img2imgの一番下のスクリプトから選択して、拡大するピクセル数や方向を設定します。

一度の処理で拡大できるピクセル数は最大256pxで、初期値は128pxです。数値によって拡大で現れる物体の形状や人のポーズが変化します。

方向は初期状態では上下左右にチェックがあり、一度の処理で全方向が拡大されます。特定の方向を拡大させたい時はそこだけチェックします。

Send to img2img(img2imgに転送)を繰り返したり、必要に応じて呪文を入れたりして少しずつ拡大させていきましょう。

また、Inpaintと併用して拡大・修正するのがとても効果的です。その際はスクリプトのオン・オフを忘れずに。

注意点としては、元画像のピクセル数があまりにも大きい場合は処理がとても遅い上に、あまり拡大されていない生成画像になってしまいます。

事前にInpaintの真ん中付近の「Resize by」やGIMPなどで縮小した画像を使用するのがおすすめです。

Quicksettingsに利用できる名前がわかんない

Settings → User Interface → User interface → Quicksettings List

よく利用される項目名をいくつか紹介する。

好きな順序で選んでいい。順序も表示に反映される。

| sd_model_checkpoint | モデルファイルの切替。デフォルトで書いてある |

| sd_vae | VAEファイルの切替 |

| CLIP_stop_at_last_layers | Clip skipの値 |

| eta_noise_seed_delta | ENSD(Eta noise seed delta)の値。昔31337が定番だったやつ |

| sd_hypernetwork | HNファイルの指定 |

| sd_lora | LoRAファイルの指定 |

| HNを適用する強さ。↓に転生した | |

| extra_networks_default_multipliers | HNとLoRAを適用する強さ(共通) |

| grid_save | ☑Always save all generated image grids グリッド画像を自動保存するかどうか |

| token_merging_ratio | ToMeの適用強度。0を指定するとToMeが無効になる |

| sd_unet | TensorRT拡張機能を利用する人向け |

名前は modules\shared.py の中身を覗いて探す。

拡張機能の分は

extensions\(拡張名)\scripts

extensions-builtin\(拡張名)\scripts とかにもあったりする。

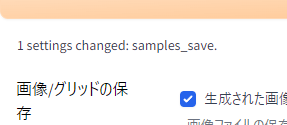

調べるのが面倒くさかったらSettingsで変更してApply settingを押すと

すぐ下に「1 settings changed: hoge_hoge.」みたいな感じで出る。

こんな感じ→

開いた時のデフォルトの数値を変えたい!よく使う呪文を最初から表示したい!

v1.3.0以降の1111なら、Settings → Other → Defaults のページを利用するのが手っ取り早い。

例えばtxt2imgのWidthやらBatch countやらの値を変更した後、

Settings → Defaults を開いてView changesボタンを押す。

すると「おめーここ変更しただろ」という感じで変更箇所がリストアップされる。

Applyを押すと、それらの内容がui-config.jsonに書き込まれる。

その後、右上のReload UIボタンを利用して一度webUI(ブラウザページ)を再読み込みすることをオススメする。

昔ながらの方法

フォルダにあるui-config.jsonをメモ帳で開いて、各項目の数値を書き換えることができます。

"txt2img/Prompt/value": ""

"txt2img/Negative prompt/value": ""

"img2img/Prompt/value": ""

"img2img/Negative prompt/value": ""

それぞれの""の中に呪文を記述すると表示されます。

その他参考になりそうな項目

基本的にtxt2imgのもの。img2imgの物はui-config.jsonの中を下にスクロールすればすぐに見つかるので省略。

| デフォルト値 | ||

| txt2img/Sampling method/value | サンプラー | DPM++ 2M Karras |

| txt2img/Sampling steps/value | ステップ数 | 20 |

| txt2img/Width/step | 画像サイズのスライダー刻み幅 | 8 |

| txt2img/Height/step | 8 | |

| txt2img/Batch count/maximum | 画像生成の繰り返し回数の上限 | 100 |

| txt2img/Batch size/maximum | 画像の同時生成枚数の上限 | 8 |

| txt2img/CFG Scale/value | プロンプトの効かせ具合 | 7.0 |

| txt2img/Hires steps/value | Hires.fixの2段階目のステップ数 | 0 |

| txt2img/Denoising strength/value | Hires.fixのノイズ除去強さ | 0.7 |

| txt2img/Denoising strength/step | ↑のスライダー刻み幅 | 0.01 |

| txt2img/Upscale by/value | Hires.fixの拡大率 | 2.0 |

| img2img/Denoising strength/value | img2imgのノイズ除去強さ | 0.75 |

| customscript/postprocessing_upscale.py/extras/Resize/value | Extrasタブの拡大率 | 4 |

※上記はv1.6.0現在(2023/9/17)のデフォルト値。

1111のアプデにより変更される可能性があり、実際に何度か変更されています。

画像生成の完了時に通知音とか出せないかな?

まず鳴らしたい音をmp3形式で用意する。

例: ![]() fu1813724.mp3

fu1813724.mp3

次にそれをnotification.mp3にリネームして1111のフォルダに突っ込む。

反映には1111のReload UIか、もしくは1111の再起動が必要かもしんない。

でも音量調整がページ毎じゃなくてブラウザ丸ごとなんだよね…。つべとかの音量まで上下しちゃう。

だから何らかの編集ソフトを使って、mp3ファイルの音量自体を調整して保存し直すのが望ましい。

Web会議中にポーン♪って鳴らしたとしあきもいるからみんなも気をつけようね。

あとSettings → Actions → Request browser notifications

でWindows 右下の通知機能をONにできる。

解除したい時はブラウザのURL欄左端の(i)のとこからたぶん行けると思う。

グリッド画像の生成が時間かかるしいらない

以下2つの設定をすることで生成しないようにできる。

- 保存無効(保存無効にするとX/Y/Z plot等の比較画像は手動で保存が必要になるので注意)

タブ「Settings」→(左メニュー)「Saving images/grids」の「Always save all generated image grids」のチェックを外す。 - 表示無効

タブ「Settings」→(左メニュー)「Gallery」の「Show grid in gallery」のチェックを外す。

VRAM消費量、多くない?

webui-user.batを実行しただけでVRAMを数GB使うのは正常?

おそらく正常。

webui-user.bat直後は、主にモデル(checkpoint)をVRAMに格納するため。

web-UIの最新化により改善する場合がある。

VRAM消費削減のオプション(--medvram等)で多少解決するけど、生成速度低下や安定性低下の原因になるため、実害がないなら放置すること。

オプションについてはより省メモリな--lowvramやSDXL利用時のみ有効な--medvram-sdxlもあるので、環境と出力内容に合わせた判断が必要。

詳しくは 「webui-user.bat」を編集するを参照。

画像生成を終えた後も、VRAM占有率がまったく減らないのは正常?

- おそらく正常。

Settingsで「Keep models in VRAM」にしているから。

web-UIの最新化により改善する場合がある。

VRAM消費削減のオプション(--medvram等)で多少解決するけど、生成速度低下や安定性低下の原因になるため、実害がないなら放置すること。 - バグの可能性もある。

- V1.3.0以前でも発生したことがあったし、v1.5.1直前でも発生することがあったぽい(画像生成失敗時)

- V1.3.0以前でも発生したことがあったし、v1.5.1直前でも発生することがあったぽい(画像生成失敗時)

共有GPUメモリってどうなの? 使ったほうがいいの?

VRAMに納まりきらずオーバーしてしまった場合にマザボ上のメモリを仮利用する機能で

グラボ上のVRAMと比べるとだいぶ処理速度が低いため、場合によっては異常に時間がかかってしまう。

ただしこの機能をOFFにした場合、VRAM容量をオーバーしてしまうと処理は強制終了する。

VRAM不足量が小さければ影響も小さく、許容できるならONのままでもかまわない。

タスクマネージャーのパフォーマンスタブ>GPU項目のメモリ使用量を出力処理中に監視した上で判断すると良い。

(関連) GeForceドライバ#共有GPUメモリの利用による速度低下問題

pngに埋め込む情報について

pngに埋め込むmodelハッシュってmodel名にはできないですか?

Settings → User Interface → Infotext → Add model name to infotext

こいつをONにすればモデル名が記載されるようになる。

1111のデフォルト設定でONになっているが、大昔の1111には無かった項目なので、設定をその頃から引き継いでいるユーザーはOFFのままになっている場合がある。もちろん好み次第なので任意にOFFにしているユーザーもいる。

1111更新によるUIの変化

アップデートしたらHistory/Image Browserが無くなった

拡張機能になりました。

使用したい場合は Extensions タブから導入してください。

stable-diffusion-webui/extensions フォルダ内で下記のコマンドを実行すればインストールできます。

git clone https://github.com/yfszzx/stable-diffusion-webui-images-browser

モデルのハッシュ値が前と違くね?

2023年1月頃の更新で変更がありました。

前のハッシュ値は短くて、マージ技術の登場以降はよく被ってたしね。

古い画像に埋め込まれたハッシュ値から使用モデルを探りたい時は、そのハッシュ値でググると参考になるかも。

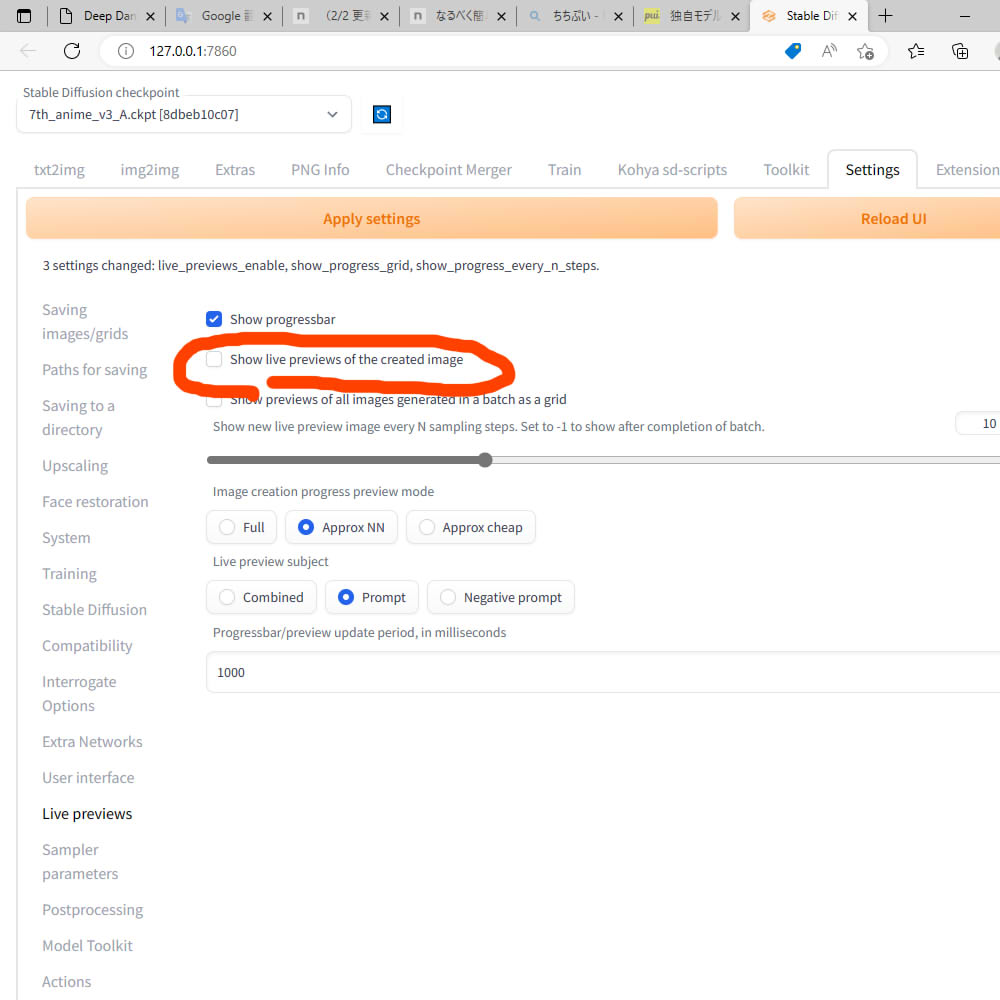

画像生成中にプレビューが出るようになった

2023年1月頃の更新からそれがデフォルトになりました。

ただ画像生成速度が結構遅くなったり、VRAM消費量が増えたりといった影響もある様子。

環境や好みによってはOFFにする方がいいかも。

Settings → User Interface → Live previews → Show live previews of the created image

Live previewsの設定次第では、プレビューをONにしつつ、生成速度やVRAM消費量への影響を少なく抑えることも可能かもしれない。

Hires.fixのUIがガラッと変わってる! 前の方が好きだった

Settings → Stable Diffusion → Compatibility → For hires fix, use width/height sliders to ~

にチェックを入れると、前の仕組みに近くなる。

具体的には「最終サイズだけ指定するから、あとは1111君がテキトーにやってよ」という形になる。初期サイズと拡大率を考えなくていい。

更新したら画面上部にあったHNの強さスライダーが消えた

ああQuicksettingsのsd_hypernetwork_strengthのことか。奴さん死んだよ。

ていうかLoRAにも対応したことで名前が変わって、extra_networks_default_multiplierになった。

整理すると、次の3つの方法がある。好みに合わせて選んでほしい。

- (方法A)LoRAタブを使う。最も主流な方法。

- (方法B)Quicksettingsを利用する。

Settings → User interface → Quicksettingsに下記の3つを書き足す。好きな順序でOK。

画面上部の Apply settings を押し、次に Reload UI も押す。sd_hypernetwork, sd_lora, extra_networks_default_multiplier, - (方法C)拡張機能: Kohya-ss Additional Networks

を導入する。

を導入する。

導入に成功すると、txt2imgやimg2imgの左下、Scriptの上辺りに Additional Networks のパネルが追加される。

LoRA(画像生成編)

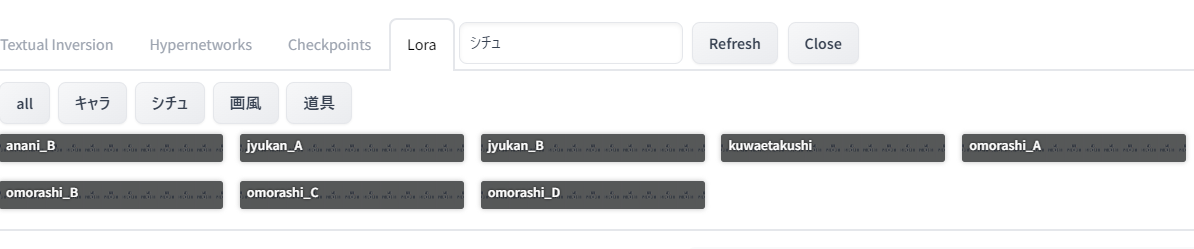

保存したLoRAの使い方がわかんない

- \models\Lora にLoRAファイルを突っ込む。

(最近の1111は起動時に該当フォルダを作る仕組みになってる。フォルダが無ければ、かなり古い1111を使ってるということ) - 1111のLoRAタブを開く。無かったら1111がかなり古いので、更新が必要。

- LoRAタブの中に目的のLoRAファイルがあるはず。見当たらなかったらRefreshを押してみる。

クリックするとプロンプトに<lora:hogehoge:1>みたいな記述が挿入される。 - さらにプロンプトにそのLoRAのためのトリガーワードや推奨タグを書き足す。

配布元のサイトがCivitaiにせよHugging Faceにせよ、大抵は説明が書いてあるのでちゃんと読もう。

単純にファイル名丸ごと、もしくはファイル名の一部がトリガーワードになってる場合もある。

サンプル画像があるならそれをPNG Infoにかけて参考にしよう。

LoRAの効果が全く出ない

- 1111を利用しているなら、コンソール画面(白黒画面)に何らかのエラーメッセージが表示されていないか確認しよう。

- <lora:hogehoge:1>の他にトリガーワードもちゃんと書き足しただろうか?

- 別のモデルで試してみる。モデルとの相性があり得る。

- 配布元のページ、またはLoRAファイルのメタデータを覗く等の方法で、ベースモデル(学習のベースに利用されたモデル)を確認する。

Aというモデルをベースに学習したLoRAなら、Aや、Aに類似したモデルでは効果を得やすい。 - ベースモデルの系列を確認する。SD1.x、SD2.x、SDXLという3つの系列の内のどれをベースに学習したLoRAなのか。

他の系列に対しては効果を得られなかったり、そもそも選択リストに表示されない場合もある。

- 配布元のページ、またはLoRAファイルのメタデータを覗く等の方法で、ベースモデル(学習のベースに利用されたモデル)を確認する。

- 品質系プロンプト、ネガティブ、ネガティブTI等による影響の可能性。

- プロンプトの((masterpiece)), (((best quality))), ((ultra-detailed)),とかが邪魔してる可能性があるので、断捨離してみる。

- ネガティブの(worst quality:1.4), (low quality:1.4), (monochrome:1.1),とかが邪魔してる可能性があるので、断捨離してみる。

- EasyNegative等のネガティブTIを利用しているなら、断捨離してみる。

キャラLoRAやポーズLoRAなのに画風がめっちゃ影響を受けちゃう

- <lora:hogehoge:1> の強弱を変更する。Ctrl+↑↓でもいいし、数値を書き換えてもいい。

0.8とか0.6みたいに加減してみてください。配布元のページに推奨値が書いてあることもよくあるよ。- 強度(weight)のデフォルト値は下記の設定からできます。

Settings → Stable Diffusion → Extra Networks → Default multiplier for extra networks

1だと強すぎる場合が多いので少し弱めな数値を設定しておくと調整楽かも。

- 強度(weight)のデフォルト値は下記の設定からできます。

- 画風まで学習しちゃってるLoRAだとか、そういう画風を想定して作成されたLoRAという可能性もあるので、ある程度諦めも肝心。

- LBW(LoRA Block Weight)

を利用するという手もある。

を利用するという手もある。

階層毎に適用強度を指定できるので、LoRAの中の、自分が欲しい要素に焦点を当てて利用できる可能性がある。

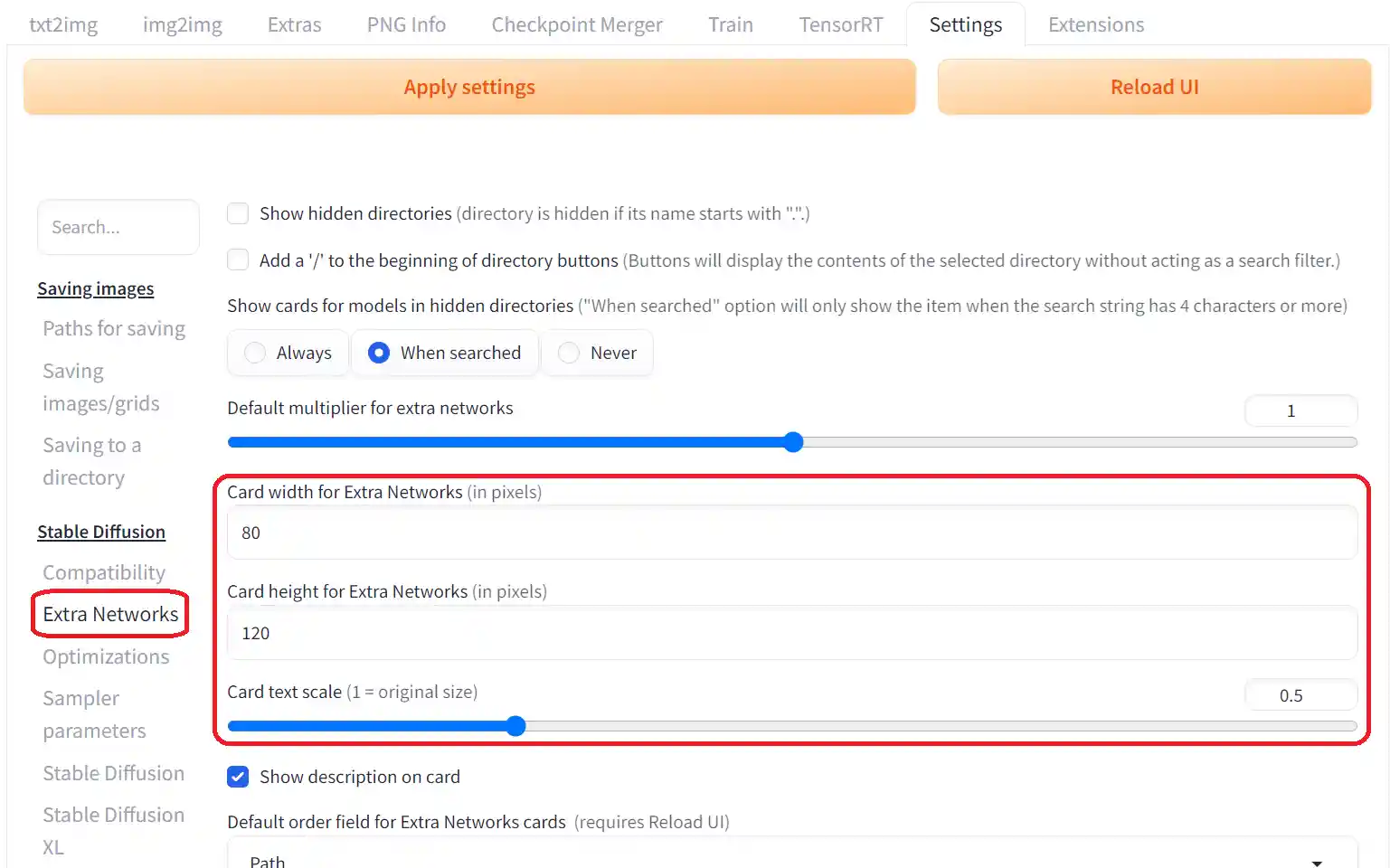

LoRAタブ等のサムネが大きい/小さい/フォントがでかい

Settings → Stable Diffusion → Extra Networks にて、モデルカードの幅と高さやテキストの表示倍率を変更できる。

- Card width for Extra Networks

- Card height for Extra Networks

- Card text scale

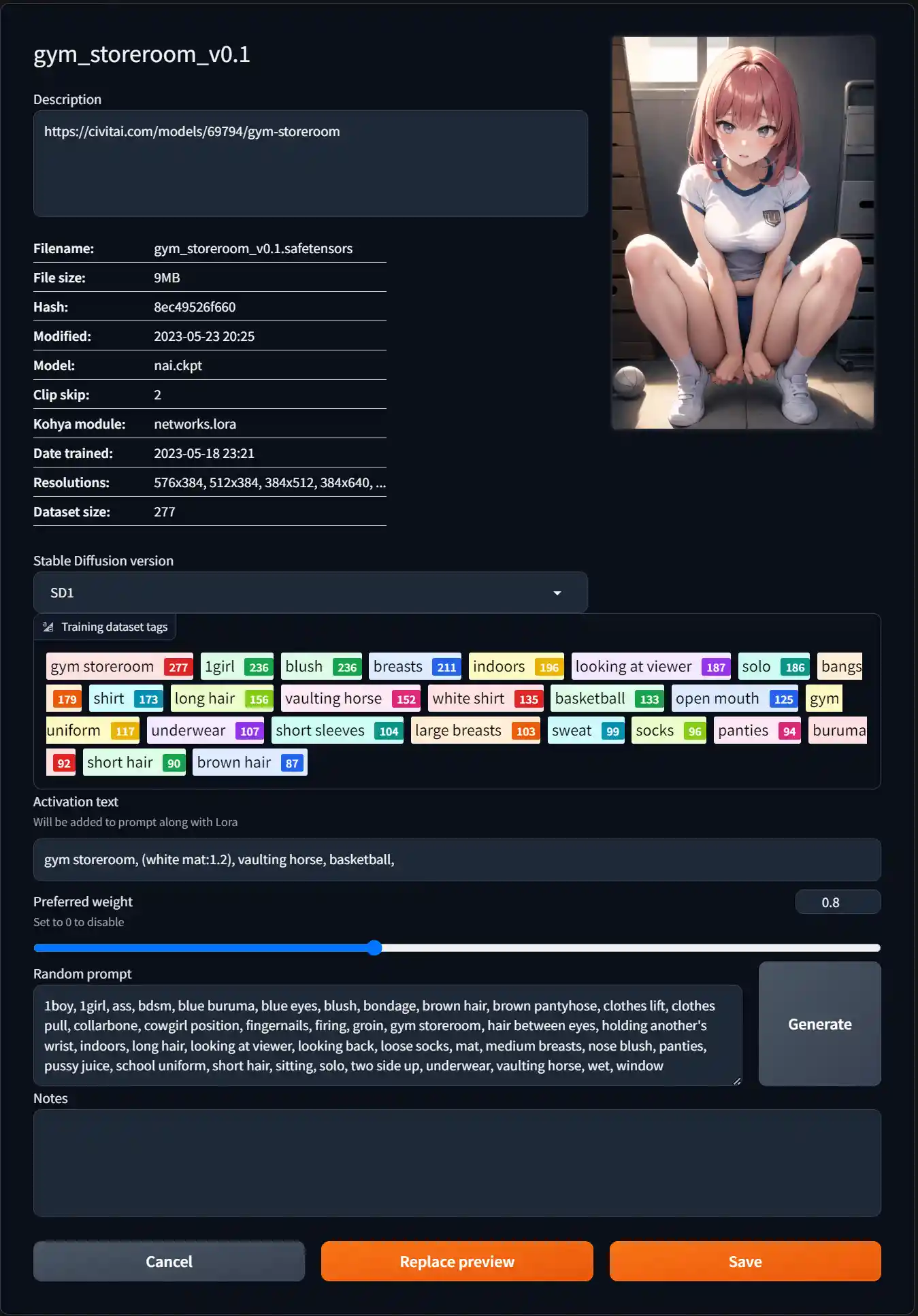

LoRAタブとかのサムネ画像ってどうやって変えるの?

下の表を参考に、自分で画像を置くのがオススメ。

| 種類 | 場所 | 学習ファイル名の例 | サムネ画像の命名規則 |

| LoRA | \models\Lora | hogehoge.safetensors | hogehoge.png |

| HN | \models\hypernetworks | hogehoge.pt | hogehoge.png |

| TI | \embeddings | hogehoge.pt | hogehoge.preview.png |

1111起動中にサムネ画像を置いたり変更した場合は、Refreshボタンを押すと表示が更新されるよ。

なおサムネ画像はpng/jpg/webp形式に対応(2023/3/12以降)。

別の方法もある。

- まず画像を生成し、画面右下のギャラリーから選択してオレンジ枠の状態にしておく。

- 次にLoRAタブ等から目的の学習ファイルにマウスカーソルを合わせ、🛠[Edit metadeta]を押す。

- 「Replace preview」を押す。

(既知の不具合)

不具合issues#v1.6.0でExtra Networksのプレビューにグリッド画像が適用されてしまう

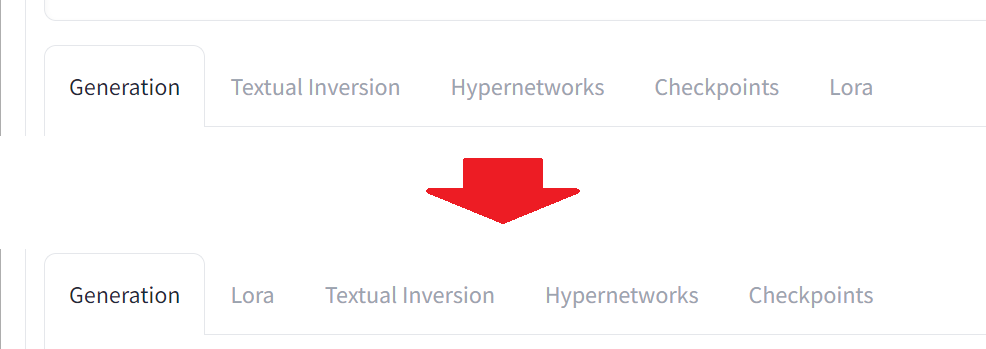

LoraタブをGenerationタブの右隣に表示させたい

LoRAは利用頻度が高いので、扱い易い位置に持って来たいよという場合。

Settings → Stable Diffusion → Extra Networks → Extra networks tab order でタブの表示順をカスタマイズできる。

ただしGenerationタブは左端で固定。

全てのタブの順序を指定する必要はない。

例えば

lora

と書けばLoraタブが左側に優先表示される。

複数のタブを指定する場合はカンマで区切る。例えば

checkpoints, lora

と指定した場合、

Generation | Checkpoints | Lora | Textual Inversion | Hypernetworks

という順番になる。

LoRAの数が沢山あって管理がしんどいっす

- 拡張機能Civitai Helperを使おうぜ!

誘導→Extensions#Civitai Helper - 自分で(Windowsのエクスプローラーで)フォルダを作って階層分けすると、1111のLoRAタブの表示もこんな感じになるから整理に便利だよ。

各LoRAのトリガーワードや推奨weightを管理する良い方法ない?

1111(v1.5.0以降)ユーザーなら🛠[Edit metadata]を押せ!

LoRAのメタデータに学習時のパラメータやコメント等が埋め込まれていれば、その内容も表示される。

- Description(説明)欄は単純にメモとして利用しても良いが、ここに記入した内容はモデルカード(サムネ)にも表示される。

表示したくない場合は、Settings → Stable Diffusion → Extra Networks → ☑Show description on card をOFFにしよう。 - Activation textにはトリガーワードや推奨プロンプトを記入して利用する。

ここに記入した内容は、モデルカードをクリックした際に、<LoRA:hogehoge:1>などと一緒に自動挿入される。

LoRA作者からの説明があるならまずはそれに従おう。メタデータに学習タグの情報が残っている場合は、そこからクリックして追加することもできる。 - Preferred weightは、デフォルトのweight(適用強度)を設定するスライダー。例えば0.8に変更すると、次回以降<LoRA:hogehoge:0.8>が挿入されるようになる。

- 変更後に「Save」を押して、変更内容を保存すること。保存前に編集画面の外をクリックすると、保存されないまま編集画面が閉じられて変更内容がパーになる、なった。「保存していない変更内容は破棄されます。本当に閉じてよろしいですか?」などという確認ダイアログは出てこないので、こまめに保存する方がいいぜ!

- 編集内容はLoRAと同じ場所に「.json」ファイルとして保存される。

LoRAが適用されない、適用するとエラーが出る

2023/5/14(?)の更新でLoRAの読み込み仕様が変更された。

その場合は以下のように元の動作に変更することで解決する可能性がある。

Settings → Compatibility → 「Lora: use old method ~」にチェック

LyCORISの場合は合わせて、拡張機能をa1111-sd-webui-loconからa1111-sd-webui-lycorisに移行する。a1111-sd-webui-lycoris

a1111-sd-webui-loconは開発が終了し最新版のwebuiには対応していない。

https://wikiwiki.jp/sd_toshiaki/-s/05ed8846

新規

新規 編集

編集 添付

添付 一覧

一覧 最終更新

最終更新 差分

差分 バックアップ

バックアップ 凍結

凍結 複製

複製 名前変更

名前変更 ヘルプ

ヘルプ