概要

Alibabaが開発したモデル。同社のAIシリーズ「Qwen」の一部。

読みは英語風に「クウェン-イメージ」でいいらしい*1。

モデル名としては「Qwen-Image」「Qwen-Image-Edit」が正式名*2。Qwen-Image-EditはQIEと略されることもある(Qwen-Imageは別のものと被るためQIと略されることはほとんどない)。

ブランド名のQwenは、中国国内では通义千问(通義千問、トンイーチエンウェン*3)と呼ばれている。

通義千問は「偏りない智慧をもって千の問いに答える」という意味。BATHの他3社がAIに精神的な名称を付けているのに対し、機能美重視の命名。

姉妹ブランドにWanこと通義万相がある。万と千という関係。

技術レポート

特徴

- 自然言語形式によるプロンプト入力に対応している。

- プロンプトに対する反応がかなり良い。

- プロンプトは英語のほか、Alibabaの母国語である中国語も通る。

- 公式では明言されていないが日本語もある程度通る*4。テキストエンコーダ自体はQwen2-VL-7B-InstructのModel cardによると欧州・アジア主要国の言語に対応している模様。

ただしこいつはLLMとして使うと怪しい日本語をしゃべる。

- 公式では明言されていないが日本語もある程度通る*4。テキストエンコーダ自体はQwen2-VL-7B-InstructのModel cardによると欧州・アジア主要国の言語に対応している模様。

- SD系に向けて書いた呪文を入れても、スラングやNSFW系でなければある程度は通る。

- テキストエンコーダにパラメータ数7Bの本格的なLLMであるQwen2.5-VL-7B-Instructを採用している。

- 7B版であれば互換性があるが、パラメータ数が異なる3B版等はQwen-Imageのテキストエンコーダとしては利用できない。

- プロンプトは英語のほか、Alibabaの母国語である中国語も通る。

- 文字の出力は英語、中国語に対応している。

- 日本語は出せないわけではないがかなり怪しい。

- 中華製なのでかアジア系の雰囲気になりやすい。他のモデルだと和風建築や和服に偏りがちな現代日本の街並みも出しやすいらしい。

- SDXLより解像度が高い。推奨解像度は1328x1328(1:1)、1664x928(16:9)、1472x1140(4:3)とその縦横回転。なお、SDXLは1024x1024。

- 潜在表現はSDXLと同様、縦横1/8の16ch*5

- Qwen Image Editは元の画像に対し、「女性を立たせる」などプロンプトで編集を加えることができる。img2imgの発展形というかControlNetを組み合わせた感じ。

- t2iも可能だが、t2iモデルより破綻が少ないものの、訓練データにない凝った組み合わせをプロンプトに沿って生成するのは苦手で、またネガティブプロンプトや高CFG値による副作用も若干出やすい傾向がある。

これは、編集モデルは条件として与えられた画像の構造を壊さないように訓練されており、結果として早期ステップで生じた構図ミス等も「所与の条件」として受け取られやすくなるため。 - WANやFLUX.1 Kontextと同様、Flow Matchingを採用している。潜在拡散モデルではノイズから完成画像への変換に限られていたが、Flow Matchingでは変換元にも任意の起点を取ることができる。

- もっともControlNetの組み合わせでも似たようなことはできる。特にNSFW二次絵については専用モデルがない現状では無理に使うほどでもないという印象。

- t2iも可能だが、t2iモデルより破綻が少ないものの、訓練データにない凝った組み合わせをプロンプトに沿って生成するのは苦手で、またネガティブプロンプトや高CFG値による副作用も若干出やすい傾向がある。

- 2025年9月時点でのライセンスはモデルも含めてApache2.0。商用利用(やNSFW等)に制限がない。独自ライセンスのSD系やFLUXより緩い。

- 200億というパラメータ数*6もありめちゃくちゃ重い。あとモデルサイズも巨大。

- fp8でようやくVRAM24GBに収まるレベル。VRAM16GBならGGUFでQ4 K_M、VRAM12GBだとQ3_K_Mまで落とさないとVRAMからあふれて牛歩になる。一応GGUF版ならVRAM8GB以下でも動作したとの報告はある。

- 画像生成モデルだけでなく、テキストエンコーダ(Qwen2.5-VL)もパラメータ数70億とSDXL本体の倍もある*7。VRAM 8GBだとfp8でもあふれる。

- Lightning Loraというstep数削減用のLoraが存在する。ただしネガティブプロンプトが効かなくなる。処理時間的には4ステップ版でようやくSDXLの20ステップ程度といったところ。

- GGUFやnunchakuといった軽量化・高速化技術の開発が進んでいる。しかしnunchakuはこれを書いている時点では発展途上で難点も多い。

- NSFWに関してはFLUXなどと同様検閲されている。

- 少年漫画レベルのグロはそんなに検閲されていないようで、NSFW用のLora等を当てずに(あるいは設定ミスで適用されてない場合とか)叡智な絵を出そうとすると崩壊してなくても血まみれな絵が出てきたりするので注意。同じくアリババ開発のWANもそうだが。

- NSFW用のLoraはあるにはあり、NSFWな格好のお姉さん程度なら出せる。が、NSFW用のベースモデルは執筆時点ではまだ出回っていないので、複数人が絡む構図をQwenに生成させるには(できるだけNSFW判定を受けない語彙で)詳細な構図指定を行う必要がある。体位だけとか雑なプロンプトを打つとおそらくベースモデル側が理解できなくて崩壊する。

- NSFW特有の部位は特に破綻しやすい。他のモデルでDetailerをかける等のケアが必要になる。

- NSFW用のLoraが適用されていて構図指定がしっかりしていれば、一応テキストエンコーダモデルがUncensored/AbliteratedでなくてもNSFW画像は生成できる。

導入方法

まだそんなに普及していないモデルなので、ComfyUIであればComfyUI公式テンプレートか誰かのワークフローを借りてきて足りないカスタムノードやモデルを一個一個落としていくのが楽。

Civitai等ではモデルばかりでなくワークフローも公開されている。

ComfyUI-nunchaku

https://github.com/nunchaku-tech/ComfyUI-nunchaku

ComfyUI用のnunchaku対応カスタムノード。(非nunchaku版に比べれば)爆速・軽量。

2025年9月現在はQwen-Image対応についてはベータ版といったところ。執筆時点ではLoRAに対応してないがすぐに対応するとのこと。

ワークフローはComfyUI-nunchakuのドキュメントからDLできる。

なお、nunchaku本体のインストールについてはNunchaku Installerという専用ノードが用意されており、こいつを1回走らせないと生成できない。

詳しくはこちら

Qwen Image Edit: テキストエンコーダ(CLIP)を変えたらエラーが出た場合

2025年9月現在、ComfyUI公式のQwen Image Editワークフローを使っている場合、同じQwen2.5-VL-7B-Instructから派生したモデルでも入れ替えるとエラーが出ることがある。

TextEncodeQwenImageEditノード上で下記のようなエラーが発生する。

mat1 and mat2 shapes cannot be multiplied (5376x1280 and 3840x1280)

このエラーを回避するにはまず、TextEncodeQwenImageEditノードを削除する。

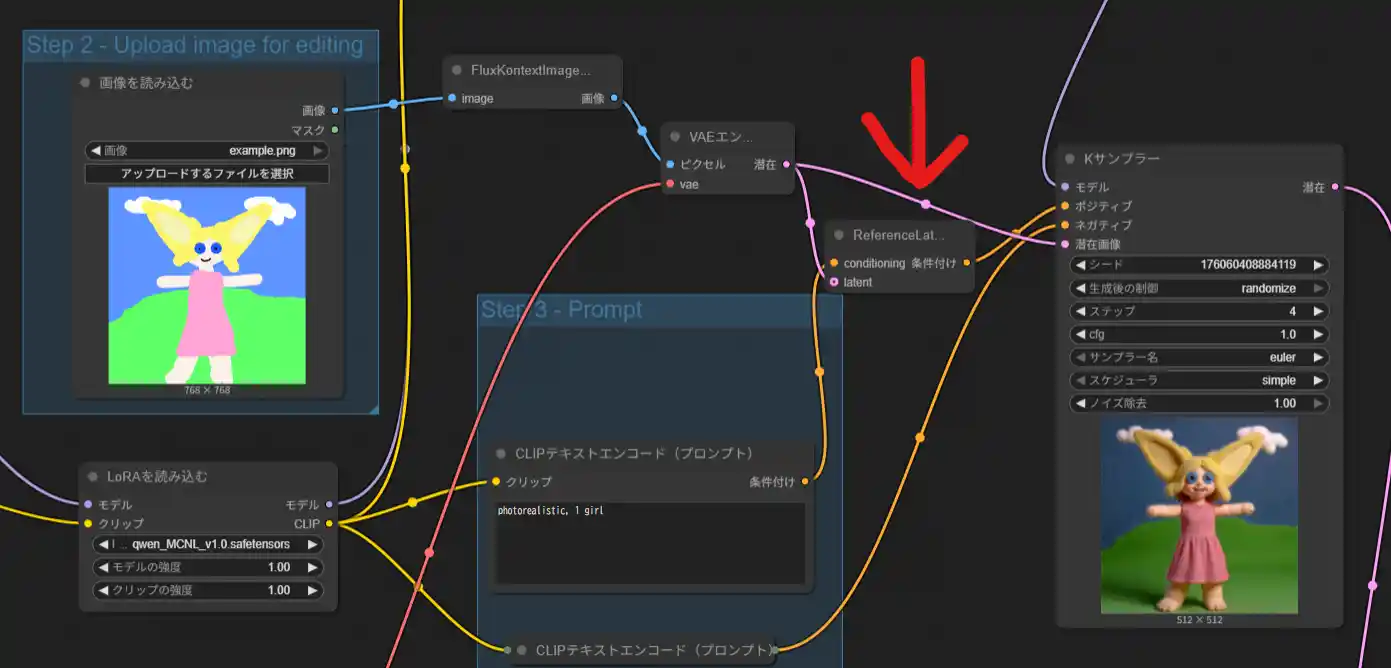

TextEncodeQwenImageEditノードの実体は、SD系モデルでも使う「CLIPテキストエンコード(プロンプト)」と「ReferenceLatent」の組み合わせ(らしい)のでそちらに置き換える。

ReferenceLatentには潜在画像の入力が必要なので、それは元画像を「VAEエンコード」して入れる。

エラー回避のためのワークフローの例

この例ではネガティブプロンプトを使っていないが、使う場合はネガ側にもReferenceLatentが必要かもしれない。

Qwen Image Editでマスクインペイントをすると雑コラ化してしまうときの対処法

LanPaintを使うと解決する。

https://github.com/scraed/LanPaint

ComfyUI-ManagerからLanPaintを検索してインストールして、今使っているQwen Image EditワークフローのKサンプラーをLanPaint KSamplerに置き換えて今まで使っていた設定にする。promptmodeはprompt firstにしておくのがおすすめ。

あとはマスクノードを追加してマスク処理すれば使える。インペイント用VAEエンコードを使うとエラーが出たので(おま環?)、通常のVAEエンコードと潜在ノイズマスクで繋ぐと解決した。

この拡張機能は、何度か生成してマスク部分と元画像部分が自然になるように調整してくれるモノ。生成回数が増える分やや時間がかかってしまうのがデメリット。

応用するとアウトペイントも可能。

ちなみにこの拡張機能はQwen以外にWan2.2やSDXLなどでも使える。インペイントの雑コラ現象に悩んでいる人は試す価値あり。

モデルの種類

- 公式モデル

- Qwen-Image (t2i用)

https://huggingface.co/Qwen/Qwen-Image - Qwen-Image-2512 (Qwen-Imageの強化版)

https://huggingface.co/Qwen/Qwen-Image-2512 - Qwen-Image-Edit (i2i用)

https://huggingface.co/Qwen/Qwen-Image-Edit - Qwen-Image-Edit-2509 (Qwen-Image-Editの強化版)

https://huggingface.co/Qwen/Qwen-Image-Edit-2509

QIEから複数画像入力、単一画像の一貫性、ControlNetサポートなどを強化。 - Qwen-Image-Edit-2511 (Qwen-Image-Edit-2509の強化版)

https://huggingface.co/Qwen/Qwen-Image-Edit-2511

2509から(複数)人物の一貫性、ライティングや視点変更LoRAの組み込みなどを強化。 - Qwen-Image-Layered

https://huggingface.co/Qwen/Qwen-Image-Layered

入力画像をキャラクター、背景、文字など複数のレイヤーに分解できるモデル

- Qwen-Image (t2i用)

- ComfyUI用 (safetensors)

TEはすべてのモデルで共通。

VAEはQwen-ImageとすべてのQIEで共通、QILのみ個別。- Qwen-Image

https://huggingface.co/Comfy-Org/Qwen-Image_ComfyUI ※diffusion model, TE, VAE - Qwen-Image-Edit

https://huggingface.co/Comfy-Org/Qwen-Image-Edit_ComfyUI ※diffusion model - Qwen-Image-Layered

https://huggingface.co/Comfy-Org/Qwen-Image-Layered_ComfyUI ※diffusion model, VAE

- Qwen-Image

- マージドモデル

- Qwen-Image-Edit-Rapid-AIO

https://huggingface.co/Phr00t/Qwen-Image-Edit-Rapid-AIO

画像生成モデルのほか、テキストエンコーダ、VAE、4ステップ高速化LoRAほか多々のLoRAをマージしたAIO(All in One)モデル。

Qwen-Image-Editベースだが参照画像を与えなければ一応t2iもできる。が、Illustrious-XL系モデルのように大規模な追加学習が行われているわけではなくあくまでLoRAの寄せ集めなので、画質はともかくマニアックな衣装指定の理解度などはt2i用途としてはいまいち。

(そもそも編集モデルは元の画像の構造を大きく崩さないよう訓練されており、仮にt2iのタスクを学んでいたとしても裁量の幅が狭い。

アリババがQIEの更新を優先しているのは、万能モデルだからというよりt2iがレッドオーシャン化しているためフロンティア領域に活路を見出していると考えたほうが自然である)

公式モデルと違ってそれぞれをバラバラにDLする必要がないので導入が多少楽。

NSFW用と一般用に分かれている。2025年12月現在頻繁にアップデートされており、推奨サンプラーなどもころころ変わるのでモデルカード必読。

- Qwen-Image-Edit-Rapid-AIO

- Lora

- Qwen-Image-Lightning (高速化Lora)

https://huggingface.co/lightx2v/Qwen-Image-Lightning

https://huggingface.co/lightx2v/Qwen-Image-2512-Lightning

https://huggingface.co/lightx2v/Qwen-Image-Edit-2511-Lightning

4~8ステップ程度でまともな絵が生成されるようになる。ただしそのステップ数で生成するにはCFG Scaleを1.0にする必要があり、そうするとネガティブプロンプトは効かなくなる。

それぞれのモデルで専用となっているため注意。 - MCNL (Multi Concept NSFW Lora) [Qwen Image]

https://civitai.com/models/1851673/mcnl-multi-concept-nsfw-lora-qwen-image

実写系のNSFW用Lora。二次絵に適用すると肌テカテカしがち&破綻しやすい。後者はLightning Loraを併用するとある程度改善される。その他、実写系なのでAVみたいな構図になりやすく漫画やヘボゲでしか見ないような構図は出ない*8。

- Qwen-Image-Lightning (高速化Lora)